Anaconda下载安装及PyTorch环境配置详细图文教程

通过Anaconda创建隔离环境,结合预配置的PyTorch-CUDA镜像,可高效规避深度学习中常见的GPU不可用、版本冲突等问题。该方案支持Jupyter交互开发与SSH远程训练,适用于个人开发者、团队协作及教学场景,大幅提升环境复现性与开发效率。

Anaconda 与 PyTorch-CUDA 环境配置实战指南

在深度学习项目开发中,最让人头疼的往往不是模型设计本身,而是环境搭建——明明代码写得没问题,却因为 torch.cuda.is_available() 返回 False,或者某个包版本冲突导致整个训练流程卡住。这种“明明该跑通”的挫败感,几乎每个刚入门的研究者都经历过。

而解决这类问题的关键,并不在于逐行排查错误日志,而在于从一开始就选择一条更稳健的技术路径:用 Anaconda 管理环境,用预配置的 PyTorch-CUDA 镜像规避兼容性陷阱。这条路不仅省时,还能确保团队协作时“你跑通的我也能跑通”。

我们先来看一个典型场景:你想在本地工作站上训练一个 Vision Transformer 模型,显卡是 RTX 3090,系统为 Ubuntu 22.04。如果按照传统方式手动安装 PyTorch + CUDA + cuDNN,大概率会遇到以下问题:

- 官网下载的 PyTorch 版本默认使用 CUDA 11.8,但你的驱动只支持到 11.7;

- 手动编译 torchvision 时提示缺少依赖库;

- 安装完成后

import torch成功,但一调用.cuda()就崩溃。

这些问题的本质,其实是 版本耦合太强:PyTorch、CUDA、cuDNN、NVIDIA 驱动、Python 解释器之间存在严格的版本对应关系,稍有不慎就会“牵一发而动全身”。

这时候,Anaconda 的价值就体现出来了。

Anaconda 并不是一个简单的 Python 发行版,它更像是一个“科学计算操作系统”。它的核心组件 Conda,不仅能管理 Python 包,还能处理非 Python 的二进制依赖(比如 CUDA 工具链),这是 pip 做不到的。更重要的是,Conda 支持创建完全隔离的虚拟环境,这意味着你可以同时拥有一个用于 PyTorch 1.12 + CUDA 11.3 的老项目环境,和另一个运行 PyTorch 2.7 + CUDA 12.1 的新项目环境,互不干扰。

安装过程也非常直观。以 Linux 系统为例:

# 下载最新版 Anaconda 安装脚本

wget https://repo.anaconda.com/archive/Anaconda3-2024.06-Linux-x86_64.sh

# 执行安装

bash Anaconda3-2024.06-Linux-x86_64.sh

安装过程中会提示你接受许可协议、选择安装路径(建议保留默认),最后询问是否初始化 Conda。这里一定要选“yes”,否则后续每次都要手动激活 base 环境。

安装完成后重启终端或执行:

source ~/.bashrc

即可启用 Conda 命令。你可以通过以下命令验证安装是否成功:

conda --version

python --version

接下来就是创建独立环境。不要直接在 base 环境里装深度学习库!这是新手常犯的错误,会导致依赖污染。正确的做法是:

# 创建名为 pytorch_env 的新环境,指定 Python 3.9

conda create -n pytorch_env python=3.9

# 激活环境

conda activate pytorch_env

此时你的命令行提示符前应该会出现 (pytorch_env) 标识,说明已进入该环境上下文。

到这里,基础环境已经搭好。但如果你打算手动安装 PyTorch,依然可能踩坑。比如下面这条官方推荐命令:

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

看起来没问题,但如果服务器没有外网访问权限,或者镜像源不稳定,下载可能会中断。更麻烦的是,某些旧显卡(如 Tesla K80)根本不支持 CUDA 11.8,强行安装只会得到一个“看似正常实则无法使用 GPU”的环境。

所以,更高效的做法是跳过安装环节,直接使用预配置好的 PyTorch-CUDA 镜像。

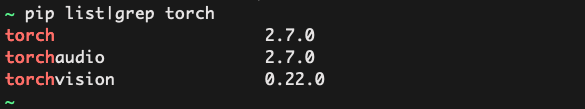

所谓 PyTorch-CUDA-v2.7 镜像,本质上是一个包含了完整运行时环境的容器镜像或系统快照,内置了:

- Ubuntu 20.04/22.04 操作系统

- NVIDIA 驱动适配层

- CUDA Toolkit ≥11.8

- PyTorch v2.7、torchvision、torchaudio

- Jupyter Notebook 与 SSH 服务

- 常用数据科学库(NumPy、Pandas、Matplotlib)

这种“开箱即用”的设计,把原本需要数小时才能完成的配置工作压缩到了几分钟内。你只需要启动镜像,就能立刻开始写模型代码。

启动后第一件事,永远是验证 GPU 是否可用。可以运行这样一段检查脚本:

import torch

print("CUDA Available:", torch.cuda.is_available())

print("GPU Count:", torch.cuda.device_count())

if torch.cuda.is_available():

print("Current Device:", torch.cuda.current_device())

print("GPU Name:", torch.cuda.get_device_name(0))

print("CUDA Version:", torch.version.cuda)

else:

print("Warning: CUDA is not available. Check your driver and installation.")

理想输出应该是:

CUDA Available: True

GPU Count: 1

Current Device: 0

GPU Name: NVIDIA GeForce RTX 3090

CUDA Version: 11.8

一旦看到 True 和具体的显卡型号,恭喜你,环境已经准备就绪。

这个环境的强大之处不仅在于本地开发,更体现在多模式接入能力上。

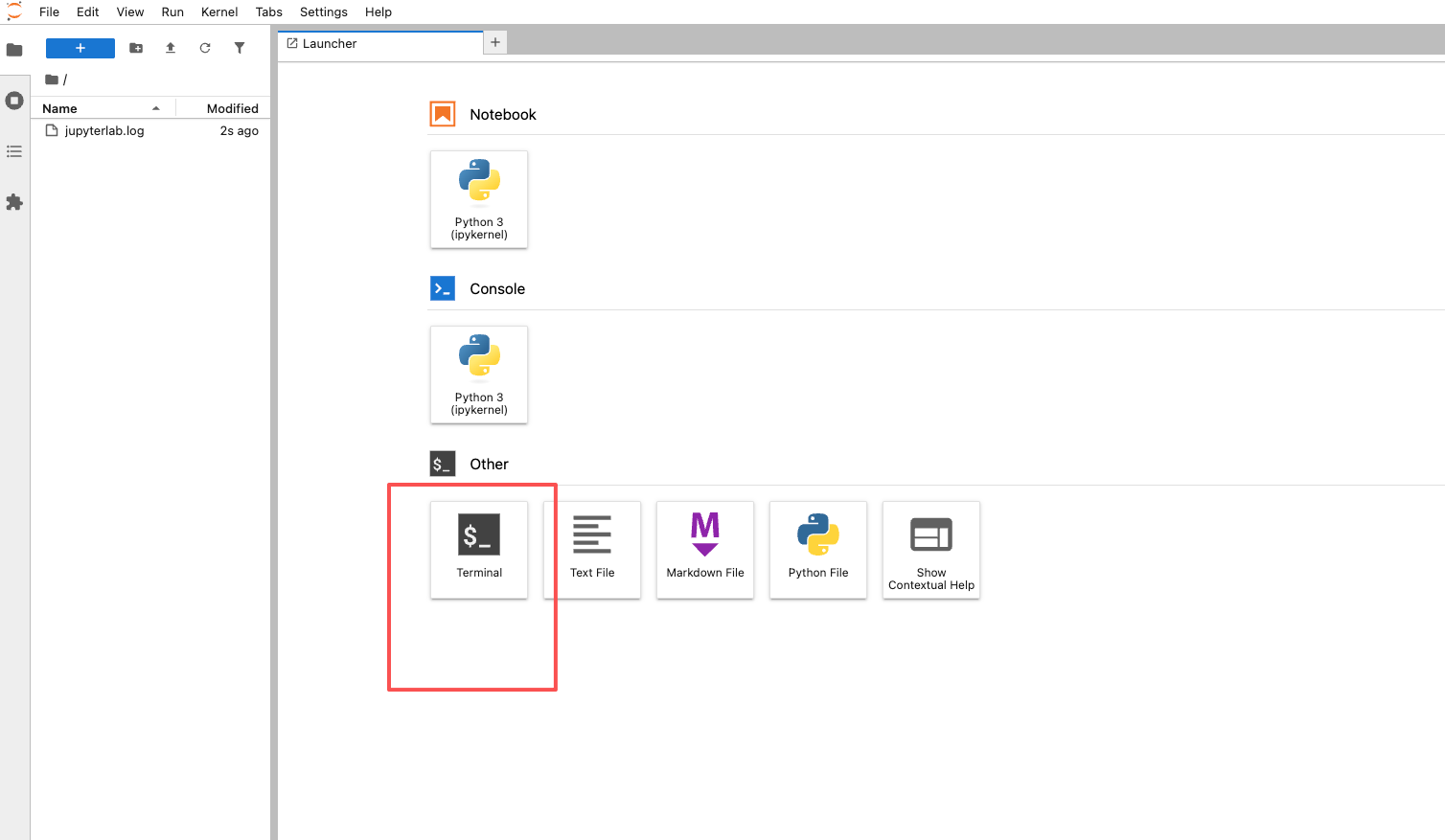

对于算法研究人员来说,Jupyter Notebook 是最高效的交互式开发工具。镜像通常会自动启动 Jupyter 服务并监听 8888 端口。你只需在浏览器中输入:

http://<服务器IP>:8888

首次访问时会要求输入 token 或设置密码。这个 token 一般会在镜像启动日志中打印出来,形如:

To access the server, open this file in a browser:

http://localhost:8888/?token=a1b2c3d4e5f6...

登录后你会看到熟悉的 Jupyter 界面,可以直接新建 .ipynb 文件,边写代码边调试模型结构。尤其适合做可视化分析、数据探索和快速原型验证。

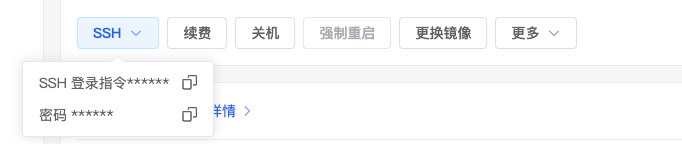

而对于需要批量训练任务的工程师,SSH 远程访问更为合适。通过标准 SSH 客户端连接服务器:

ssh username@server_ip -p 22

登录后即可进入命令行环境,执行 Python 脚本、提交 Slurm 作业或监控训练进程。配合 screen 或 tmux 工具,还能实现断线不中断训练。

图示:Jupyter 提供图形化开发体验,适合交互式调试

图示:SSH 支持脚本化操作,更适合自动化任务

当然,即使用了预配置镜像,也有一些工程细节需要注意。

首先是安全性。默认开启 SSH 服务存在一定风险,建议:

- 修改默认端口(如改为 2222),减少被扫描攻击的概率;

- 禁用 root 用户远程登录;

- 使用 SSH 密钥认证替代密码登录。

其次是资源管理。GPU 是昂贵资源,必须实时监控其利用率。nvidia-smi 是必备工具:

watch -n 1 nvidia-smi

这条命令每秒刷新一次 GPU 状态,包括显存占用、温度、功耗等关键指标。如果发现显存泄露或 GPU 利用率长期低于 30%,就需要回头检查数据加载器或模型结构。

再者是数据持久化。很多用户习惯把代码和数据直接放在容器内部,结果一次重启全没了。正确做法是将重要目录挂载为外部卷,例如:

docker run -v /host/data:/workspace/data -v /host/code:/workspace/code ...

这样即使容器销毁,数据依然保留在宿主机上。

最后是网络策略。开放 Jupyter 端口(8888)时务必配置防火墙规则,限制仅允许特定 IP 段访问,避免敏感模型和数据暴露在公网中。

这套基于 Anaconda 和 PyTorch-CUDA 镜像的方案,已经在多个实际场景中证明了其价值:

- 在高校实验室,导师可以统一分发镜像给学生,确保所有人实验条件一致;

- 在企业 AI 团队,MLOps 工程师可以用它快速部署测试环境,加速模型上线周期;

- 在在线教育平台,学员无需折腾本地环境,直接通过 Web IDE 接入云端 GPU 实训;

- 对个人开发者而言,哪怕只有一台带独显的笔记本,也能借助 WSL2 + Docker 搭建出媲美工作站的开发环境。

更重要的是,它改变了我们对“环境配置”的认知:不再把它视为每次项目开始前的负担,而是作为可复用、可版本化的基础设施来管理。就像代码有 Git,数据有数据库,运行环境也应该有标准化的交付方式。

当你下次面对一个新的深度学习项目时,不妨换个思路:不要急着写代码,先花十分钟确认你的运行环境是否可靠。用 Anaconda 隔离依赖,用预置镜像绕开兼容性雷区,让 GPU 从第一天起就为你所用。毕竟,真正的生产力提升,往往来自于那些“看不见”的底层建设。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)