【AI大模型实战】微调Deepseek-Qwen模型, 四种应用场景+个人开发者零成本实践

本文详细介绍了大模型微调技术,以DeepSeek-R1-Distill-Qwen-7B为例,展示四种高价值应用场景,分析个人开发者零成本实现微调的可能性,并提供实用避坑指南,帮助开发者快速掌握大模型微调,让AI更懂特定领域。

前言

大家一定接触过不少大模型(LLM),对ChatGPT、DeepSeek、Qwen等可以说是耳熟能详。这些通用大模型虽然可以拿来直接使用,但是对于一些“私域”的信息无法触及到,缺少相应的训练数据,普遍面临 “水土不服” 的困境 —— 难以精准适配特定领域的术语体系、业务逻辑与合规要求。通常,我们有两三种方式来解决这个问题:

-

增强检索增强生成(Retrieval-augmented Generation),也就是我们熟悉的RAG。

-

大模型微调(LLM Fine-tuning)。

-

增强检索增强生成+大模型微调。

RAG和Fine-tune没有好坏之分。很多人都会问我要做XXX是用RAG好还是微调好?我想说,两者并没有冲突,完全可以都试一下。

今天我们先在之前几篇文章讨论BERT做文本分类的基础上,来介绍一下第二种方法:大模型微调(LLM Fine-tuning)。

本次选用的出场选手是:

DeepSeek-R1-Distill-Qwen-7B(别问为什么,问就是穷,只能跑7B的模型)

一、先懂基座:DeepSeek-R1-Distill-Qwen-7B 的微调基因

要理解微调价值,首先需明确这款模型的核心优势。DeepSeek-R1-Distill-Qwen-7B 作为一款融合 DeepSeek R1 千亿级模型知识与 Qwen-7B 轻量化优势的蒸馏模型,它并非简单的 7B 参数模型,而是通过数据蒸馏 + 模型蒸馏的双重技术路径,从 DeepSeek R1(671B 参数)教师模型中迁移了关键推理能力,同时保持轻量化特性,这种特质让其微调落地具备天然优势。

核心技术特性与微调适配性

| 技术特性 | 具体表现 | 微调价值 |

|---|---|---|

| 高效知识迁移 | 基于 80 万条教师模型推理样本 SFT 训练,AIME 2024 Pass@1 达 55.5% | 微调起点高,少量领域数据即可实现性能跃升 |

| 轻量化架构 | 7B 参数量,4bit 量化后体积可压缩至 4GB 以下 | 支持本地化部署,微调硬件门槛低(我用的是4090D) |

| 推理效率优势 | T4 GPU 上单句推理延迟 < 200ms,比同级别模型快 30% | 微调后可满足实时交互场景需求 |

| 中文能力优化 | 融合 Qwen 系列中文处理优势与 DeepSeek 推理能力 | 适配中文垂直领域微调需求 |

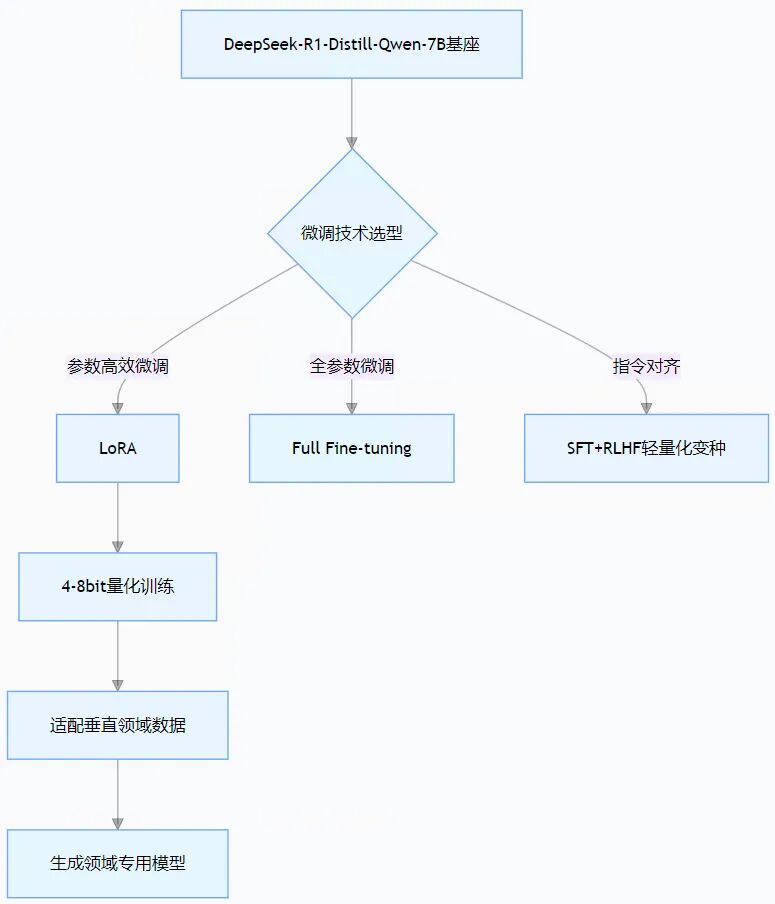

主流微调技术路径选择

针对该模型的特性,业界已形成成熟的微调方案,其中LoRA(Low-Rank Adaptation) 因性价比最高成为首选,配合量化技术可进一步降低落地成本。

这里我们采用的是参数高效微调(LoRA),LoRA通过冻结预训练模型参数并引入低秩矩阵实现高效训练,其核心优势在于显著减少显存占用和计算资源需求(通常 1%-5%)。与全参数微调等其他方法相比,LoRA在资源占用和训练效率上更具优势。

二、落地实战:四大高价值微调应用场景

基于该模型微调的应用已在多个行业实现规模化落地,核心价值集中在效率提升、成本降低、风险控制三大维度。以下结合具体案例展开解析。

场景 1:垂直领域智能助手 —— 法律合规专员

法律行业对精准性和依据性要求极高,通用大模型常因回答宽泛、缺乏法条支撑难以实用。通过微调 DeepSeek-R1-Distill-Qwen-7B,可快速打造企业级法律合规助手。

技术实现方案

- 数据准备:采用复旦大学 DISC-Law-SFT 数据集(40.3 万条标注数据),筛选企业合规相关子集(合同审查、劳动纠纷、知识产权等)。

- 微调策略:基于 LLaMA Factory 框架,使用 LoRA(r=32,学习率 3e-4)进行 2 轮训练,重点优化法律要素提取和法条关联能力。

- 进阶优化:结合 RAG 技术对接企业私有法条库,实现 “检索 + 生成” 双驱动。

场景 2:工业设备运维顾问 —— 智能制造 “诊断师”

制造企业的设备运维依赖专业经验,老技师知识难以规模化传承。通过微调模型对接设备手册与故障案例,可打造实时运维助手。

技术实现方案

-

数据准备:整理 5000 条设备故障案例(含故障现象、排查过程、解决方案)、300 万字设备手册,转换为 “问题 - 思考链 - 答案” 格式。

-

微调策略:采用 “增量预训练 + 指令微调” 双阶段方案,先用设备手册进行预训练注入专业术语,再用故障案例做 SFT。

-

部署方式:4bit 量化后部署于边缘服务器,对接设备传感器数据接口。

场景 3:企业级代码助手 —— 研发效率加速器

软件开发场景中,通用代码模型常因不熟悉企业技术栈导致生成效果差。微调后可适配特定语言框架与编码规范。

技术实现方案

-

数据准备:收集企业内部 10 万条高质量代码片段(含 Python、Java、前端框架)、5000 个常见开发问题解决方案。

-

微调优化:结合 AST 语法树解析技术,重点优化代码生成的语法正确性与框架适配性。

-

集成方式:通过 SDK 嵌入企业 IDE,支持实时代码补全、bug 修复、文档生成。

-

**场景 4:公文写作辅助 —— 政务与企业高效文书助手

不管是政府单位写通知、报告,还是企业拟请示、函件,公文都有严格的格式规范、用语要求 —— 比如 “请示” 必须一文一事,“报告” 不能夹带请求事项,通用模型常犯 “格式错、用语不正式” 的问题。通过微调 LLM,能让模型变成 “会写公文的秘书”,大幅减少修改时间。**

-

**技术实现方案

数据准备:核心是 “规范数据 + 业务数据” 双结合 —— 先收集《党政机关公文处理工作条例》、各行业公文格式标准(比如企业常用的 “请示”“批复” 模板),再补充单位近 2 年的正式公文(如年度工作报告、对外函件),总共整理约 8000 条标注数据,每条都标注 “公文类型 + 格式要求 + 核心要素”(比如 “通知类公文 —— 需包含‘发文机关、事由、执行时间’”)。**

-

微调策略:重点优化 “格式正确性” 和 “用语规范性”—— 用 LoRA(r=24,学习率 2e-4)做 3 轮训练,训练时专门加入 “错误案例纠正” 任务(比如给模型一段格式错误的请示,让它修改并说明原因),确保模型不仅能写,还能 “纠错”。

-

功能设计:部署时增加 “模板选择 + 要素填充” 功能 —— 用户选 “请示” 类型,输入 “请示事项(如申请采购设备)、预算金额、执行时间”,模型能自动生成符合格式的公文,还会标注 “需盖章位置”“报送部门” 等关键信息。

三、价值量化:个人开发者的微调投入开销

聊完场景,个人开发者最关心的肯定是:“我自己做微调,要花多少钱?” 其实对个人来说,微调的成本几乎可以忽略不计。

投入成本构成(个人场景)

个人做微调,完全不用花大价钱,成本主要分三类,甚至很多能零成本搞定,以下是从我个人的角度总结的:

| 成本类型 | 具体项目 | 金额范围 | 省钱技巧 |

| 算力成本 | 云端 GPU / 本地电脑 | 0-50 元(租赁) 0(我公司提供的) 12999(自己买一台4090) | 优先用 Colab 免费 GPU,不够再用阿里云按需付费(T4 每小时 1.2 元,单次训练 1-2 小时);家用电脑 8G 显存以上能本地跑,成本≈0 |

| 数据成本 | 数据整理 / 标注 | 0 元 | 用自己过去的作品(比如文章、文案)当数据,不用花钱买;开源平台(如 Hugging Face)有免费的规范数据(如公文模板),直接下载用 |

| 工具成本 | 框架 / 软件 | 0 元 | 全用开源工具:LLaMA Factory、AutoGPTQ、Chinese-LLaMA-Alpaca,不用买付费软件;教程网上到处都是,不用报培训班 |

| 总计 | - | 0-50 元 | 多数场景能零成本搞定,最多花几十块钱应急 |

我几乎没花一分钱,唯一的开销就是“我的时间”“我的生命”。

四、避坑指南:个人开发者微调的 “少走弯路” 技巧

个人做微调,不用追求完美,重点是 “快速试错、及时调整”。分享三个我踩过的坑,帮你少走弯路:

-

数据不用多,但要 “像你自己”:别想着 “数据越多越好”,个人微调 50-200 条高质量数据就够了。关键是数据要和你的需求匹配 —— 比如你想让模型写公文,就喂你自己单位的材料,别喂公众号长文,不然模型学错了风格。

-

别纠结 “算力不够”:很多人觉得 “我电脑显存不够,做不了微调”,其实完全不用。Colab 免费 GPU 能应付大多数场景,就算不够,按需付费的云端 GPU 也很便宜,单次训练几块钱,不用买昂贵的服务器。我用 8G 显存的笔记本电脑,照样能跑 4bit 量化的 LoRA 训练。

-

先做 “最小可用版本”,再优化:别一开始就追求 “模型要多精准”,先快速做一个简单的微调版本试试 —— 比如先让模型学会写某一类文案,能用就行,然后根据实际使用情况慢慢优化。比如我第一次微调文案模型,只训练了 100 条数据,虽然还有点小问题,但已经能帮我省时间了,后来再慢慢加数据优化,效果越来越好。

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)