DeepSeek-R1大模型本地部署详细指南:一篇文章全掌握

在快速发展的人工智能领域,2025 年 1 月,DeepSeek正式推出了备受瞩目的推理大模型。这款模型凭借其低廉的成本和卓越的性能,一经发布便迅速在 AI 行业掀起波澜,吸引了众多研究者、开发者以及企业的广泛关注。之所以能够在竞争激烈的 AI 市场中脱颖而出,其性价比优势功不可没。相较于其他同类型的大模型,它在保证出色性能的同时,大大降低了使用成本,这使得更多的个人开发者、科研团队以及预算有限的

在快速发展的人工智能领域,2025 年 1 月,DeepSeek 正式推出了备受瞩目的 DeepSeek-R1 推理大模型。这款模型凭借其低廉的成本和卓越的性能,一经发布便迅速在 AI 行业掀起波澜,吸引了众多研究者、开发者以及企业的广泛关注。

DeepSeek-R1 之所以能够在竞争激烈的 AI 市场中脱颖而出,其性价比优势功不可没。相较于其他同类型的大模型,它在保证出色性能的同时,大大降低了使用成本,这使得更多的个人开发者、科研团队以及预算有限的企业能够轻松应用,为推动 AI 技术的普及和发展提供了新的契机。

DeepSeek 充分考虑到不同用户的多样化需求和使用场景,提供了多种灵活的使用方式。其中,本地部署方式具有诸多显著优势。在数据安全方面,将模型部署在本地,用户的数据无需上传至云端,极大地降低了数据泄露的风险,尤其适用于对数据保密性要求较高的行业和领域,如医疗、金融等。在性能上,本地部署可以根据本地硬件配置进行优化,减少网络延迟,实现更快速的响应。对于有定制化需求的用户,能够在本地对模型进行个性化调整和训练,以满足特定的业务需求。从成本角度来看,长期使用本地部署可能会比依赖云端服务更具成本效益,特别是对于大规模应用的场景。此外,本地部署还确保了离线可用性,即使在没有网络连接的情况下,依然能够正常运行。对于追求技术自主性的用户和团队来说,本地部署让他们能够更好地掌控模型的运行和维护,减少对外部服务的依赖。

对于广大开发者以及习惯使用命令行操作的技术爱好者而言,在电脑上部署 Deepseek 其实并非难事。整个过程只需准备安装一款名为Ollama的软件,以下是详细的安装步骤:

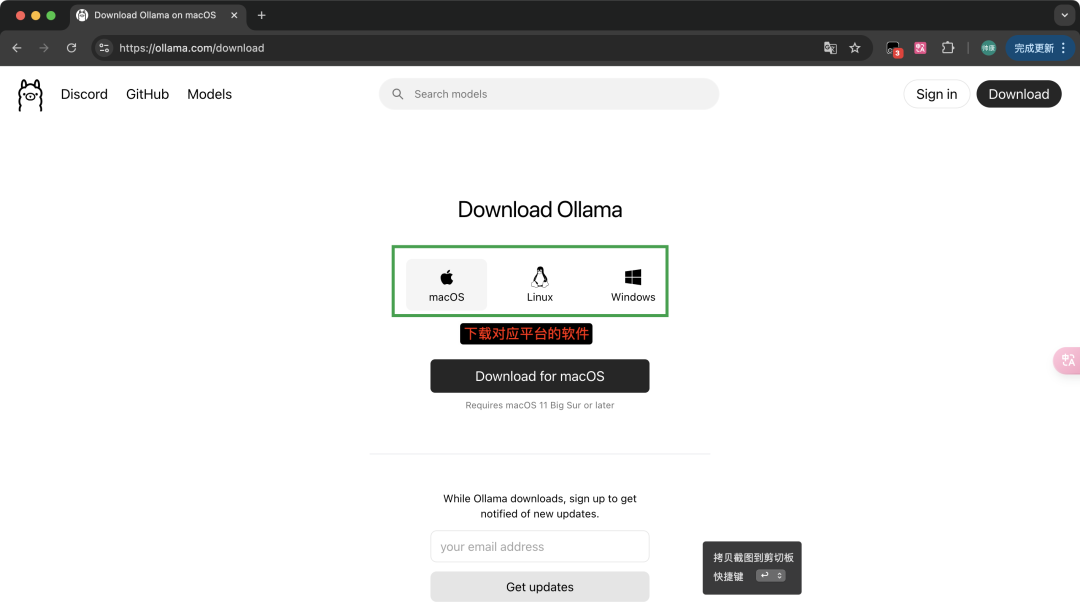

一、下载 Ollama 安装程序

Ollama官方网站:https://ollama.com/

Windows 系统:

-

打开常用的浏览器,如 Chrome、Firefox 或 Edge。

-

在官网的下载页面,找到适用于 Windows 系统的安装包,通常为.exe 格式。根据你的系统是 32 位还是 64 位,选择对应的版本进行下载。下载完成后,文件会保存在你浏览器设置的默认下载路径中,或者你在下载时指定的保存位置。

macOS 系统:

-

同样使用 Safari、Chrome 等浏览器,访问 Ollama 官方网站。

-

在下载页面,找到 macOS 版本的安装文件,一般为.dmg 格式。点击下载,下载完成后,在 “访达” 的 “下载” 文件夹中可以找到该文件。

Linux 系统:

-

打开终端。对于基于 Debian 或 Ubuntu 的系统,在终端中输入命令:sudo apt-get install -y wget && wget <Ollama官方下载链接>,这里的<Ollama官方下载链接>需要替换为官网提供的实际下载链接。下载完成后,文件会保存在当前工作目录。

-

对于基于 Red Hat 或 CentOS 的系统,在终端输入:sudo yum install -y wget && wget <Ollama官方下载链接> ,同样替换为实际下载链接。

二、安装 Ollama

Windows 系统:

-

找到下载好的 Ollama 安装文件(.exe 格式),双击运行。

-

安装向导启动后,首先会弹出用户账户控制窗口,询问是否允许该程序对你的设备进行更改,点击 “是”。

-

在安装界面,按照提示逐步操作。一般会先显示许可协议,仔细阅读后勾选 “我接受协议”,然后点击 “下一步”。

-

选择安装路径,你可以使用默认路径,也可以点击 “浏览” 选择其他磁盘位置进行安装,确定路径后点击 “下一步”。

-

接着可以选择是否创建桌面快捷方式等附加任务,根据个人需求勾选或取消,之后点击 “安装”。

-

安装过程中会显示进度条,等待安装完成,安装完成后点击 “完成” 即可。

macOS 系统:

-

打开 “访达”,找到下载的 Ollama 安装文件(.dmg 格式),双击打开。

-

会弹出一个包含 Ollama 图标和应用程序文件夹图标的窗口,将 Ollama 图标拖动到应用程序文件夹图标上,即可完成安装。安装完成后,你可以在 “应用程序” 文件夹中找到 Ollama。

Linux 系统:

-

对于基于 Debian 或 Ubuntu 的系统,下载完成后,在终端中输入命令:sudo dpkg -i <Ollama安装包文件名>,这里的<Ollama安装包文件名>替换为你实际下载的文件名。如果安装过程中提示缺少依赖包,根据提示使用sudo apt - get install命令安装相应依赖后,再次运行安装命令。

-

对于基于 Red Hat 或 CentOS 的系统,在终端输入:sudo rpm -ivh <Ollama安装包文件名>,同样替换为实际文件名。若提示依赖问题,按照提示安装依赖后重新安装。

需要注意的是,Ollama没有直观的用户界面,它在后台默默运行。

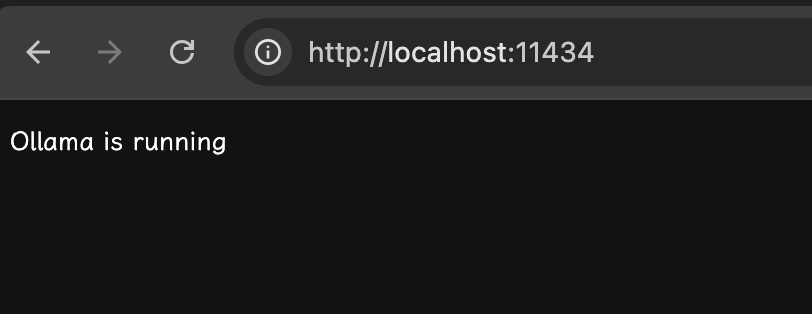

三、验证 Ollama 是否成功安装

-

安装完成后,打开浏览器,在地址栏中输入 “http://localhost:11434/” 。

-

如果页面显示 “Ollama is running”,则表明Ollama已经成功启动并正在运行。若显示无法访问或其他错误信息,可能是端口被占用,需要检查系统中占用 11434 端口的程序并进行处理,或者重新配置 Ollama 的运行端口。

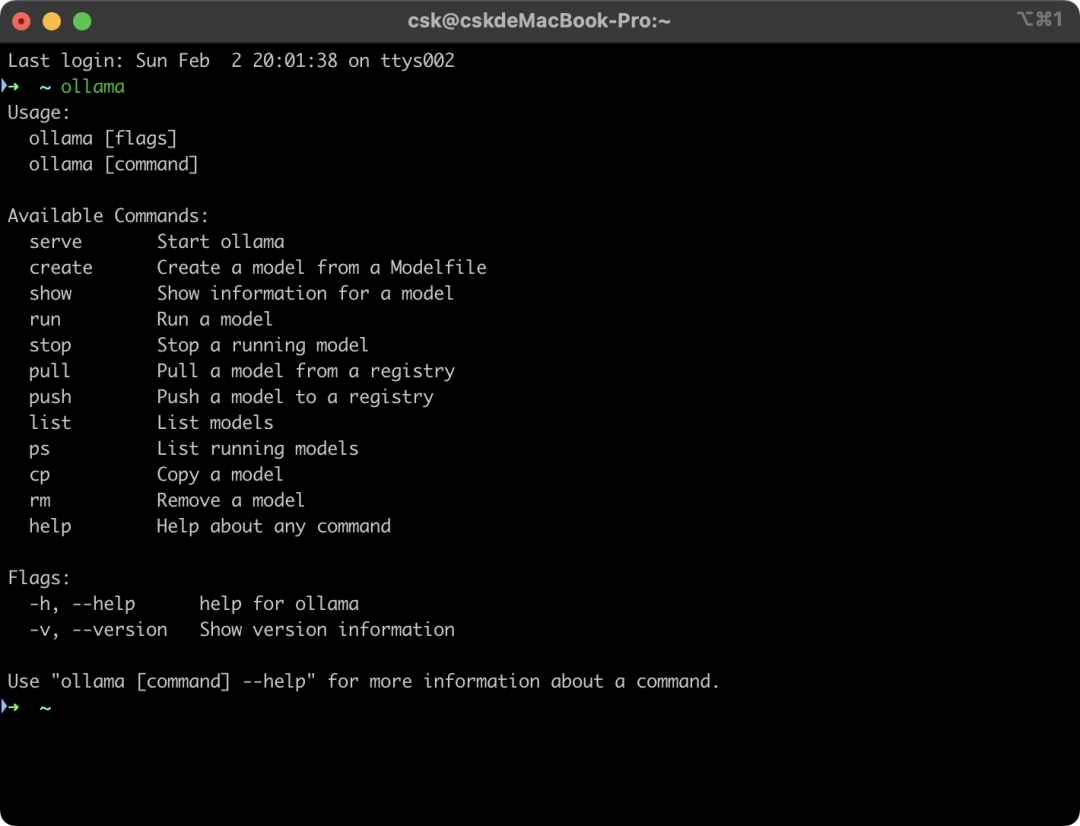

四、了解 ollama 命令用法

-

打开一个命令行终端。在 Windows 系统中,可以通过搜索 “命令提示符” 或 “PowerShell” 打开;在 macOS 系统中,打开 “终端” 应用;在 Linux 系统中,本身就在终端环境下操作。

-

在终端中输入ollama命令,此时会显示详细的命令用法,这些用法为后续的操作提供了重要的指导。例如,显示的命令可能包括ollama run(用于运行模型)、ollama pull(用于下载模型)等基本命令及其参数说明。

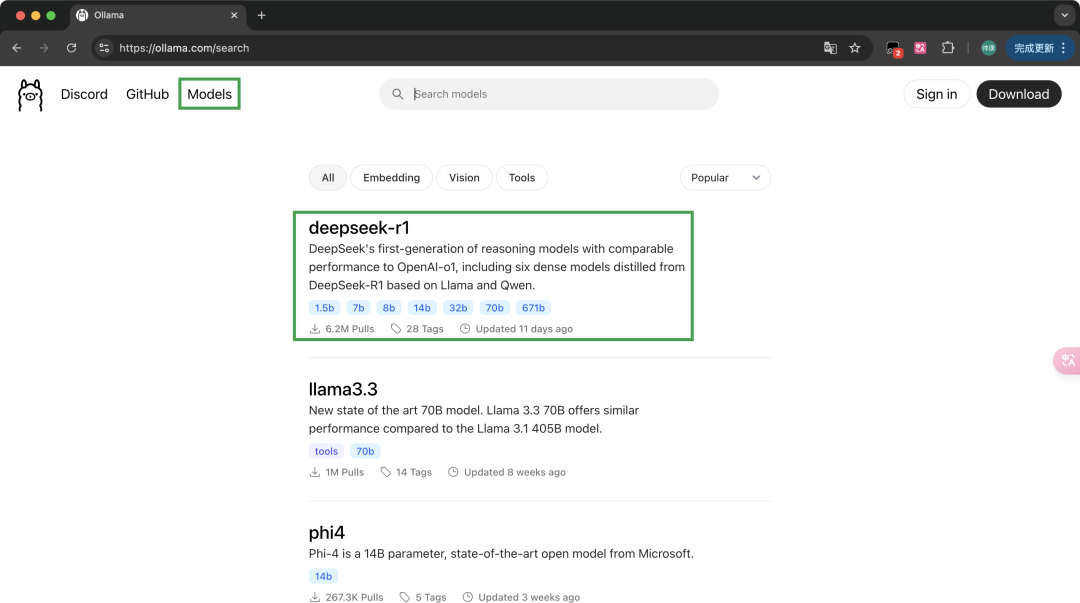

五、下载 DeepSeek-R1 模型

-

通过 ollama 客户端命令,我们可以轻松下载所需的模型。它支持的模型种类丰富,具体的模型和对应的下载命令,可以在官网进行查询。

-

打开浏览器,访问 Ollama 官网,切换到官网的 “Models” 页面。

-

在 Models 页面中,找到 DeepSeek-R1 模型。可以看到它拥有多种参数可供选择,通常情况下,对于使用 macOS 系统的用户,选择 7b、8b 参数即可满足日常使用需求。需要注意的是,参数越大,对显卡和内存的要求也就越高。如果你的电脑配备了 3090 显卡、4090 显卡等高性能硬件,那么可以尝试选择 32b、70b 等更大的参数。一般来说,参数越大,模型的效果越好,性能也越强大,但同时也需要更多的存储和计算资源来支持其运行。例如,1.5b 模型的参数规模为 15 亿,占用存储空间约 1.1GB;7b 模型的参数约为 70 亿,占用空间约 4.7GB;14b 模型的参数约为 140 亿,占用空间约 9GB。

-

根据自己的硬件条件和需求,选择对应的蒸馏模型,将官网提供的对应的下载命令复制到 ollama 控制台。例如,如果选择 7b 参数的 DeepSeek-R1 模型,复制对应的ollama pull deepseek-r1:7b命令到终端,然后按回车键即可开始本地安装。

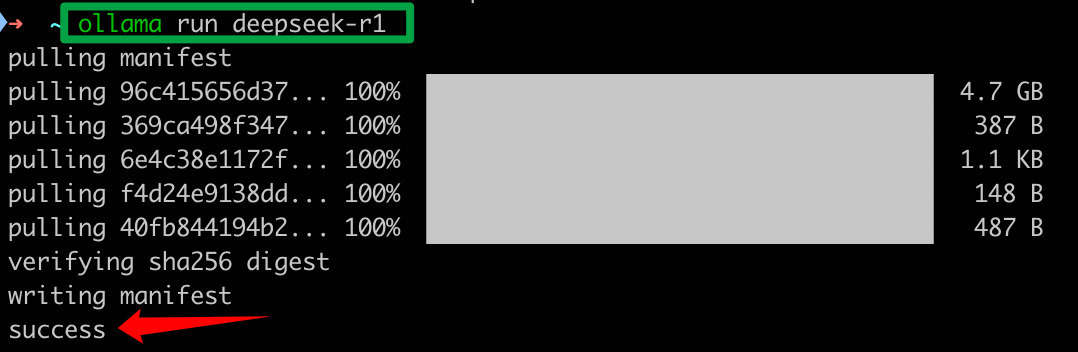

六、安装过程及等待

-

输入下载命令后,终端会显示下载进度,包括已下载的字节数、下载速度以及预计剩余时间等信息。

-

下载过程中,可能会因为网络波动等原因出现下载中断的情况。如果出现这种情况,可以重新输入下载命令,Ollama 通常会支持断点续传,继续从上次中断的位置开始下载。

-

下载完成后,Ollama 会自动进行模型的安装和配置,这个过程可能需要一些时间,根据硬件性能不同,时间长短会有所差异。在安装配置过程中,终端会显示相关的日志信息,如模型文件的解压、依赖项的检查等。

七、开启对话

当安装完成的那一刻,你就可以开启与 DeepSeek-R1 的对话之旅。在命令行终端中输入ollama run deepseek - r1:7b(这里的参数根据你实际下载的模型参数而定),然后输入你想要询问的问题或指令,即可体验它强大的语言处理能力和智能交互功能,探索无限的 AI 应用可能。

AI大模型学习福利

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)