三大大模型微调技术对比:LoRA vs AdaLoRA vs QLoRA,让你的AI训练效率提升10倍

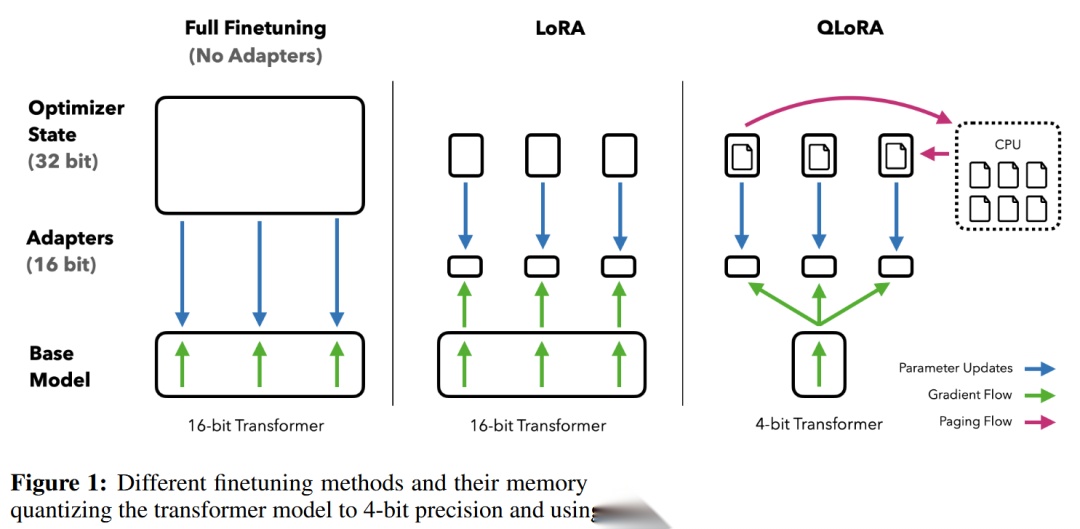

文章详解三种大模型参数高效微调技术:LoRA通过低秩矩阵分解减少可训练参数;QLoRA引入4位量化技术进一步降低内存需求;AdaLoRA动态调整低秩矩阵秩以适应不同任务。这些方法显著降低资源消耗,同时保持模型性能,使个人开发者在有限硬件条件下高效微调大模型。

文章详解三种大模型参数高效微调技术:LoRA通过低秩矩阵分解减少可训练参数;QLoRA引入4位量化技术进一步降低内存需求;AdaLoRA动态调整低秩矩阵秩以适应不同任务。这些方法显著降低资源消耗,同时保持模型性能,使个人开发者在有限硬件条件下高效微调大模型。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

问题背景

在大规模预训练语言模型(如GPT-3)的下游任务适应中,如何高效地减少可训练参数数量和计算资源消耗,同时避免现有方法(如adapter或前缀调优)的局限性(如推理延迟或序列长度限制)。

背景

- 全量微调的局限性:全量微调需要为每个下游任务存储和维护与原模型相同规模的参数(如GPT-3的175B参数),导致存储成本高昂,且硬件要求极高。

- 现有方法的不足:

- Adapter:引入额外的推理延迟(需顺序计算

adapter layers)。 - Prefix-tuning:占用输入序列长度,限制任务处理能力。

- 参数效率不足:其他方法(如BitFit)在性能上无法与全量微调媲美。

相关研究

LoRA解决的问题绝非新问题。自迁移学习诞生以来,已有数十项工作致力于使模型适应更节省参数和计算资源。以语言建模为例,高效适应主要有两种策略:添加adapter layers(Houlsby等,2019;Rebuffi等,2017;Pfeiffer等,2021;Rücklé等,2020)或优化输入层激活的某些形式(Li & Liang,2021;Lester等,2021;Hambardzumyan等,2020;Liu等,2021)。然而,这两种策略均存在局限性,尤其在大规模和延迟敏感的生产场景中。

adapter layers引入推理延迟

adapter有多种变体。Houlsby等(2019)的原始设计(每个Transformer块包含两个adapter layers)和Lin等(2020)的最新设计(每个块仅一个adapter layers,但额外包含LayerNorm(Ba等,2016))。尽管可以通过剪枝层或利用多任务设置(Rücklé等,2020;Pfeiffer等,2021)降低总体延迟,但无法直接绕过adapter layers的额外计算。由于adapter layers通过小瓶颈维度设计(参数有时<原模型的1%)限制了浮点运算量,这看似无关紧要。然而,大型神经网络依赖硬件并行性来降低延迟,而adapter layers必须顺序处理。在批大小通常仅为1的在线推理场景中,这会导致显著差异。在无模型并行的通用场景(例如在单个GPU上运行GPT-2(Radford等,b)中型模型),即使瓶颈维度极小,使用adapter也会显著增加延迟(表1)。

当需要如Shoeybi等(2020)和Lepikhin等(2020)所述对模型进行分片时,问题会更严重,因为增加的深度需要更多同步GPU操作(如AllReduce和Broadcast),除非adapter参数被多次冗余存储。

Directly Optimizing the Prompt难以奏效

以Prefix Tuning(Li & Liang,2021)为代表的另一方向面临不同挑战。Prefix Tuning难以优化,且其性能随可训练参数数量非单调变化,与原论文结论一致。更根本的是,为适应预留部分序列长度必然减少可用于处理下游任务的序列长度,这可能导致提示调优的性能低于其他方法。

表1:推理延迟对比

| 批大小 | 序列长度 | 可训练参数 | 全量微调/LoRA | AdapterL | AdapterH |

|---|---|---|---|---|---|

| 32 | 512 | 0.5M | 1449.4±0.8 | 1482.0±1.0 (+2.2%) | 1492.2±1.0 (+3.0%) |

| 16 | 256 | 11M | 338.0±0.6 | 354.8±0.5 (+5.0%) | 366.3±0.5 (+8.4%) |

| 1 | 128 | 11M | 19.8±2.7 | 23.9±2.1 (+20.7%) | 25.8±2.2 (+30.3%) |

注:在NVIDIA Quadro RTX8000上测量GPT-2中型模型单次前向传播的推理延迟(毫秒),取100次试验平均值。AdapterL和AdapterH为两种adapter变体(见5.1节)。在线短序列场景中,adapter layers引入的延迟显著。完整研究见附录B。

核心挑战

如何在保证模型性能的前提下,通过参数高效的方式实现以下目标:

- 降低存储和计算成本:减少可训练参数数量,降低硬件需求。

- 避免推理延迟:在部署时不引入额外的计算开销。

- 保持灵活性:支持快速任务切换,共享预训练模型的大部分参数。

问题定义

假设有一个由 参数化的预训练自回归语言模型 。例如, 可以是基于Transformer架构(Vaswani等,2017)的通用多任务学习器,如GPT(Radford等,b;Brown等,2020)。考虑将此预训练模型适配到下游条件文本生成任务,如摘要、机器阅读理解(MRC)和自然语言到SQL(NL2SQL)。每个下游任务由context-target pairs的训练数据集 表示,其中 和 均为token序列。例如,在NL2SQL中, 是自然语言查询, 是对应的SQL命令;在摘要任务中, 是文章内容, 是其摘要。

在全量微调期间,模型初始化为预训练权重 ,并通过反复跟随梯度最大化条件语言建模目标,更新为 :

max _ Φ ∑ _ ( x , y ) ∈ Z ∑ _ t = 1 ∣ y ∣ log ( P _ Φ ( y _ t ∣ x , y _ < t ) ) \max\_{\Phi} \sum\_{(x, y) \in \mathcal{Z}} \sum\_{t=1}^{|y|} \log \left(P\_{\Phi}\left(y\_t | x, y\_{<t}\right)\right) max_Φ∑_(x,y)∈Z∑_t=1∣y∣log(P_Φ(y_t∣x,y_<t))=“” 全量微调的主要缺点之一是,每个下游任务需要学习一组不同的参数 ,其维度 等于 。因此,如果预训练模型规模很大(如 亿的GPT-3),存储和部署多个独立的微调模型实例将变得非常困难,甚至不可行。

本文采用更参数高效的方法,其中任务特定的参数增量 进一步由更小的参数集Θ编码,且 。寻找 的任务因此转化为优化Θ:

max _ Θ ∑ _ ( x , y ) ∈ Z ∑ _ t = 1 ∣ y ∣ log ( P _ Φ _ 0 + Δ Φ ( Θ ) ( y _ t ∣ x , y _ < t ) ) \max\_{\Theta} \sum\_{(x, y) \in \mathcal{Z}} \sum\_{t=1}^{|y|} \log \left(P\_{\Phi\_0 + \Delta \Phi(\Theta)}\left(y\_t | x, y\_{<t}\right)\right) max_Θ∑_(x,y)∈Z∑_t=1∣y∣log(P_Φ_0+ΔΦ(Θ)(y_t∣x,y_<t))=“” 提出使用低秩表示编码 ,以实现计算和内存高效。当预训练模型为GPT-3 175B时,可训练参数的数量可低至 的0.01%。

核心方法

LoRA适用于深度学习模型中的任何密集层,设计简单。 **Low-Rank Adaptation (LoRA)**,通过冻结预训练模型权重,在Transformer架构的每一层注入可训练的低秩分解矩阵(秩为r),仅优化这些低秩矩阵。LoRA在以下方面解决问题:

- 参数效率:将可训练参数减少10,000倍(如GPT-3的175B参数 35MB)。

- 计算效率:减少GPU内存消耗(如GPT-3训练内存从1.2TB降至350GB),提高训练吞吐量。

- 无推理延迟:通过将低秩矩阵与原权重合并,部署时与全量微调模型一致。

LoRA在多个模型(RoBERTa、DeBERTa、GPT-2、GPT-3)和任务(GLUE、E2E NLG、SAMSum等)上表现与全量微调相当或更优,同时显著降低资源消耗,证明了其有效性。

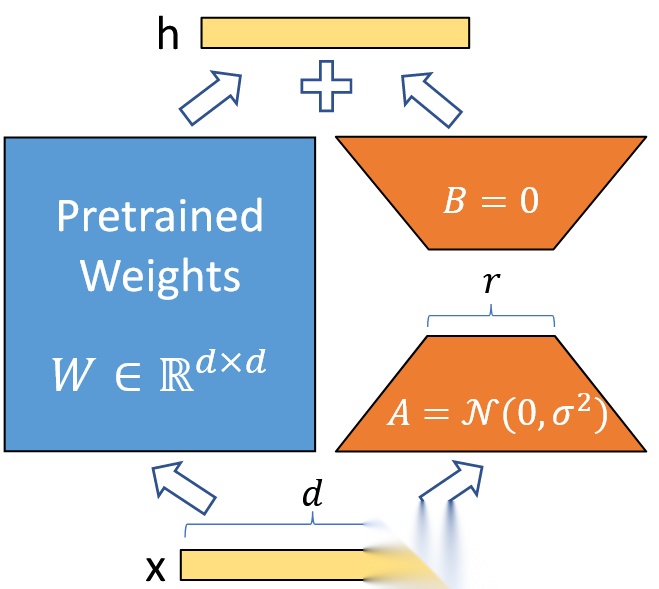

图1 Reparametrization(重参数化) only train A and B

低秩参数化更新矩阵

神经网络包含许多执行矩阵乘法的密集层,这些层的权重矩阵通常为满秩。在适应特定任务时,Aghajanyan等(2020)表明,预训练语言模型具有低“内在维度”,即使随机投影到较小子空间仍能高效学习。 受此启发,假设适应过程中权重的更新也具有低“内在秩”。 对于预训练权重矩阵 ,通过低秩分解约束其更新:,其中 、,且秩 。训练期间, 保持冻结,不接收梯度更新,而A和B包含可训练参数。注意, 和 与同一输入相乘,其输出向量按元素相加。对于 ,修改后的前向传播为:

在图1中展示了重新参数化过程。对使用随机高斯初始化,对使用零初始化,因此训练初期 为。随后,将 乘以 ,其中是与相关的常数。使用Adam优化时,调整α的效果与调整学习率类似(若初始化适当缩放)。因此,简单地将设置为首次尝试的值,无需调优。这种缩放有助于减少在调整时重新调优超参数的需求(Yang & Hu,2021)。

全量微调的泛化:更一般的微调形式允许训练预训练参数的子集。LoRA进一步要求权重矩阵的累积梯度更新在适应过程中无需为满秩。这意味着,当将LoRA应用于所有权重矩阵并训练所有偏置时(偏置参数相对于权重可忽略),通过将LoRA秩设置为预训练权重矩阵的秩,可大致恢复全量微调的表达能力。换句话说,随着可训练参数数量的增加(适应困难任务时的必然需求),训练LoRA将逐渐收敛到训练原模型,而基于适配器的方法收敛到MLP,基于前缀的方法则收敛到无法处理长输入序列的模型。

无额外推理延迟:在生产部署中,可显式计算并存储 ,并照常进行推理。注意, 和 均属于 。切换到其他下游任务时,可通过减去恢复,再添加新的,这一操作快速且内存开销极低。关键在于,通过构造保证推理时不会引入比全量微调模型更多的延迟。

在Transformer中应用LoRA

原则上,可将LoRA应用于神经网络中任意子集的权重矩阵以减少可训练参数数量。在Transformer架构中,自注意力模块包含四个权重矩阵(),MLP模块包含两个。尽管输出维度通常被划分为注意力头,仍将(或)视为维度为的单个矩阵。为简化和提高参数效率,仅考虑适应自注意力权重,冻结MLP模块(下游任务中不训练)。

实际优势与局限:

- 最显著的优势来自内存和存储使用的减少。对于使用Adam训练的大型Transformer,若,可将VRAM使用减少至多2/3,因为无需为冻结参数存储优化器状态。在GPT-3 175B上,训练期间VRAM消耗从1.2TB降至350GB。当且仅适应

query和value投影矩阵时,检查点大小减少约10,000倍(从350GB降至35MB)。这使能够用更少的GPU训练,并避免I/O瓶颈。 - 另一优势是部署时通过仅交换LoRA权重(而非所有参数),可更低成本地切换任务。这允许在VRAM中存储预训练权重的机器上动态创建和切换多个定制模型。还观察到,与全量微调相比,GPT-3 175B的训练速度提升了25%,因为无需为绝大多数参数计算梯度。

LoRA也存在局限性。例如,若选择将 和 合并到 中以消除额外推理延迟,则无法在单次前向传播中为不同任务的批量输入动态选择不同的 和。不过,对于延迟不敏感的场景,可选择不合并权重,并动态为批量中的样本选择使用的LoRA模块。

理解LOW-RANK UPDATES

鉴于LoRA的实证优势,希望进一步解释下游任务中学习到的低秩适应的性质。低秩结构不仅降低了硬件门槛,还提高了更新权重与预训练权重相关性的可解释性。聚焦于GPT-3 175B,在此模型中实现了最大幅度的减少可训练参数(高达10,000倍)且未对任务性能产生不利影响。 通过一系列实证研究回答以下问题:

- 参数预算受限的情况下,应在预训练Transformer的哪些权重矩阵上应用LoRA以最大化下游性能?

- 最优适应矩阵 是否真的秩不足?若如此,实际应用中应选择何值的秩r?

- 与原权重的关系? 是否与高度相关? 相对于的幅度有多大?

对问题(2)和(3)的回答为预训练语言模型在下游任务中的应用提供了理论依据。

应在Transformer的哪些权重矩阵上应用LoRA?

在参数预算有限的情况下,应选择哪些类型的权重进行LoRA适应以获得最佳下游任务性能?仅考虑自注意力模块中的权重矩阵。在GPT-3 175B上设置18M的参数预算(FP16存储约35MB),这对应于为所有96层适应一种注意力权重时r=8,或适应两种注意力权重时r=4。结果如表5所示。

| 权重类型 | 秩r | 可训练参数=18M | WikiSQL(±0.5%) | MultiNLI(±0.1%) |

|---|---|---|---|---|

| W_q | 8 | - | 70.4 | 91.0 |

| W_k | 8 | - | 70.0 | 90.8 |

| W_v | 8 | - | 73.0 | 91.0 |

| W_o | 8 | - | 73.2 | 91.3 |

| W_q, W_k | 4 | - | 71.4 | 91.3 |

| W_q, W_v | 4 | - | 73.7 | 91.3 |

| W_q, W_k, W_v, W_o | 2 | - | 73.7 | 91.7 |

表5:在GPT-3不同注意力权重上应用LoRA的验证准确率。同时适应W_q和W_v在参数相同的情况下性能最佳。

仅将参数分配给 或 会导致性能显著下降,而同时适应和(秩4)则取得最佳结果。这表明即使秩为4, 仍能捕获足够信息,因此优先适应更多权重矩阵而非单一权重矩阵的更高秩。

LoRA的最优秩是多少?

研究秩对模型性能的影响。适应组合包括、,并单独适应作为对照。

| 权重类型 | r=1 | r=2 | r=4 | r=8 | r=64 |

|---|---|---|---|---|---|

| 73.4 | 73.3 | 73.7 | 73.8 | 73.5 | |

| 74.1 | 73.7 | 74.0 | 74.0 | 73.9 | |

| 68.8 | 69.6 | 70.5 | 70.4 | 70.0 | |

| MultiNLI | 91.3 | 91.4 | 91.3 | 91.6 | 91.4 |

表6:不同秩r在WikiSQL和MultiNLI上的验证准确率。令人惊讶的是,对于,秩1已足够。

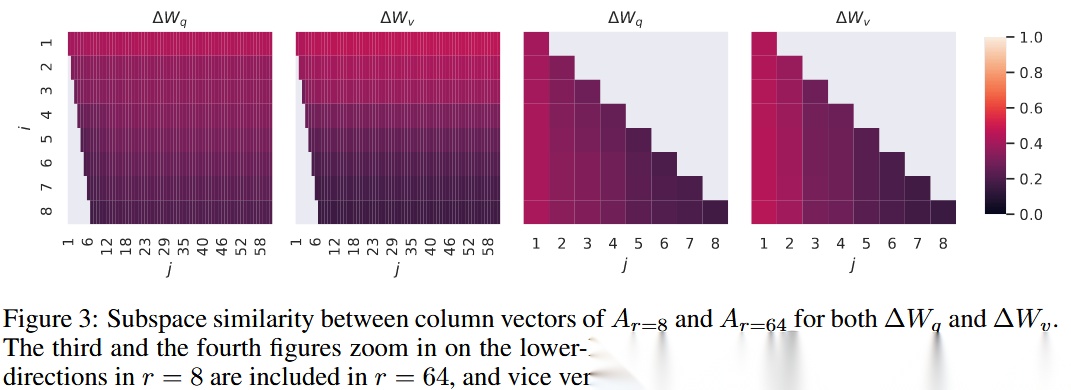

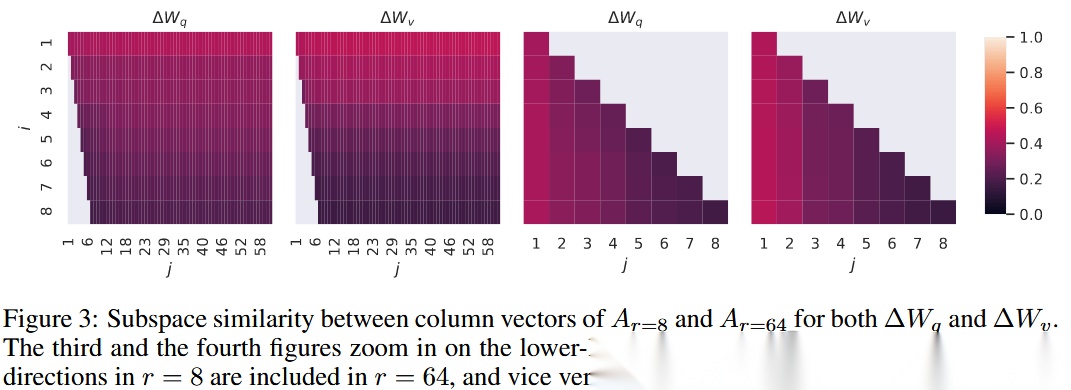

子空间相似性分析

通过计算不同秩模型的子空间重叠来验证低秩有效性。图3展示了和的 与 的列空间相似性。观察到:

-

r=8的 ( )与的 ( )共享1维子空间(相似度>0.5),解释了在GPT-3任务中的良好表现。

-

不同随机种子的模型在 的子空间相似性高于 (图4),与表6中 需要更高秩的现象一致。

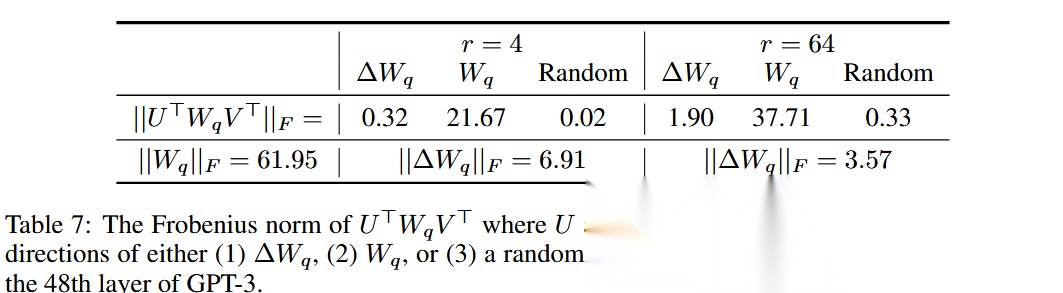

与原权重W的关系如何?

通过以下分析揭示 与的关联:

- 相关性: 在的子空间投影范数(表7)表明, 与的相关性显著高于随机矩阵,但未重复的主导奇异方向。

- 幅度放大: 的Frobenius范数相对于其在W子空间的投影放大倍数达21.5倍(r=4时),表明 选择性放大任务相关特征。

表7:不同子空间下W_q的投影范数对比。 的子空间与的低秩方向高度相关,但选择性放大特定特征。

通过实验验证发现:

- 权重选择:优先适应W_q和W_v可获得最佳性能。

- 秩选择:对于GPT-3,秩1-4通常足够,验证了低秩假设。

- 特征机制: 通过放大预训练中未被强调的任务相关特征实现高效适应。

ADALORA

“

Zhang, Qingru, Minshuo Chen, Alexander Bukharin, Nikos Karampatziakis, Pengcheng He, Yu Cheng, Weizhu Chen和Tuo Zhao. 《AdaLoRA: Adaptive Budget Allocation for Parameter-Efficient Fine-Tuning》. arXiv, 2023年12月20日. https://doi.org/10.48550/arXiv.2303.10512.

问题背景

背景

基于Transformer的模型

典型的Transformer模型由L个堆叠的块组成,每个块包含两个子模块:多头注意力(MHA)和全连接前馈网络(FFN)。给定输入序列 ,MHA在h个头中并行执行注意力函数:

其中 是输出投影矩阵, 分别是第i个头的查询、键和值投影矩阵。FFN模块由两个线性变换和中间的ReLU激活函数组成:

其中 和 。最终,通过残差连接和层归一化(Ba et al., 2016)增强模型性能。

低秩适应

LoRA(Hu et al., 2022)通过两个小矩阵的乘积建模预训练权重的增量更新。对于线性变换 ,修改后的前向传播为:

其中 , 和 ,且 。A通常初始化为随机高斯矩阵,B初始化为零矩阵以保证训练初期 。Hu et al. (2022) 仅在MHA的查询和值投影(即 和 )中应用LoRA。He et al. (2022) 将其扩展到FFN的权重矩阵(即 和 ),进一步提升了性能。他们还提出了一个统一框架,涵盖适配器微调、前缀调优等多种参数高效方法。

问题

解决的核心问题是参数高效微调中固定预算分配策略的次优性。现有方法(如LoRA)通常将增量更新的参数预算平均分配到所有预训练权重矩阵,忽略了不同模块和层的重要性差异。例如,前馈网络(FFN)和顶层的权重矩阵对模型性能的影响更大,但均匀分配预算无法充分利用这些关键部分。论文提出AdaLoRA,通过动态调整每个权重矩阵的秩(基于重要性评分),实现预算的自适应分配,从而提升模型在低预算下的性能。

方法

基于SVD的适应

提出将预训练权重矩阵的增量更新参数化为奇异值分解形式:

其中 和 表示Δ的左右奇异向量,对角矩阵 包含奇异值 ,且 。将第i个奇异值和对应向量组成的三元组记为 。Λ初始化为零,P和Q采用随机高斯初始化以保证训练初期Δ=0。为强制P和Q的正交性(即 ),引入正则化项:

直接对每个Δ计算SVD的计算复杂度为 ,无法处理大规模模型。相比之下,的参数化方法避免了密集的SVD计算,且仅需保留奇异值(而非完整矩阵),显著降低了计算开销。

基于重要性的秩分配

将SVD适应应用于每个Transformer层的所有权重矩阵()。通过迭代修剪低重要性的奇异值控制预算:

-

重要性评分:设计结合奇异值和向量的评分函数:

其中 采用平滑后的敏感性指标:

是指数平滑后的梯度-权重乘积, 量化局部不确定性。

-

动态修剪:每个训练步后根据评分修剪奇异值:

若在前名否则

全局预算调度器

采用三阶段预算调度策略:

- 初始阶段:预算 ,每个矩阵初始秩

- 衰减阶段:按立方函数衰减预算:

- 稳定阶段:固定最终预算 进行微调

该调度策略通过先探索后聚焦的方式提升训练稳定性。

算法总结

Algorithm 1 AdaLoRA1: 输入: 数据集D, 总迭代次数T, 预算调度{b(t)}T, 超参数η, γ, β1, β22: for t = 1 to T do3: 采样小批量数据计算梯度∇L(P, E, Q)4: 计算所有参数的敏感性I(t)5: 更新平滑敏感性I和不确定性U6: 计算三元组重要性S(t)7: 更新P和Q的参数8: 根据预算b(t)修剪奇异值Λ9: end for10: 输出: 微调后的参数{P(T), E(T), Q(T)}

QLORA(Quantized Low-Rank Adapter)

“

Dettmers, Tim, Artidoro Pagnoni, Ari Holtzman和Luke Zettlemoyer. 《QLoRA: Efficient Finetuning of Quantized LLMs》. arXiv, 2023年5月23日. https://doi.org/10.48550/arXiv.2305.14314.

关键公式与术语

- 块级量化:通过分块独立量化减少异常值影响。

- LoRA:通过低秩矩阵分解减少可训练参数,降低内存消耗。

- 梯度检查点:通过动态计算梯度减少内存峰值。

论文解决的核心问题是如何在大幅降低内存消耗的同时,实现对大型语言模型(LLM)的高效微调,使得即使是65B参数规模的模型也能在单个消费级GPU上完成训练,同时保持与全精度(16位)微调相当的性能。

问题背景

传统的全精度(16位)微调对硬件要求极高。例如,微调LLaMA 65B模型需要超过780GB的GPU内存,这使得大多数研究人员和机构难以负担。现有的量化方法仅适用于推理阶段,无法在训练过程中保持稳定性和性能。因此,如何在训练阶段实现高效的低精度微调成为关键挑战。

块级k位量化

量化是将输入从高信息量表示转换为低信息量表示的过程,通常指将高位数据类型(如32位浮点数)转换为低位数据类型(如8位整数)。为了充分利用低位数据类型的范围,通常通过输入元素的绝对最大值对数据进行归一化。例如,将32位浮点数(FP32)张量量化为范围在[-127, 127]的Int8张量:

其中 是量化常数。反量化过程为:

为避免异常值导致的量化 bin 利用率不足,通常将输入张量划分为独立量化的块,每个块使用独立的量化常数 。具体而言,将输入张量 分割为 个块,每个块大小为 ,并分别应用公式(1)进行量化。

低秩适配器(LoRA)

低秩适配器微调 [28] 通过引入少量可训练参数(适配器)减少内存需求,同时固定预训练模型参数。梯度通过固定的预训练模型权重反向传播至适配器。给定线性投影 ,LoRA 的计算为:

其中 和 是低秩矩阵, 为缩放因子。

参数高效微调的内存需求

LoRA 的内存占用主要来自激活梯度而非适配器参数。例如,对于7B LLaMA模型,LoRA参数仅占26MB,而输入梯度在批量大小为1时占用567MB(使用梯度检查点后降至18MB/序列)。这表明梯度检查点是关键优化手段,但减少LoRA参数对整体内存节省有限。因此,使用更多适配器(覆盖所有网络层)可在不显著增加内存的前提下提升性能。

QLORA的解决方案

提出的两种技术实现了高精度的4位微调:4位正态浮点(NF4)量化和双重量化。此外,引入分页优化器以防止梯度检查点过程中的内存峰值导致内存不足错误,这一问题传统上使得单台机器上的大模型微调变得困难。

QLORA 使用一种低精度存储数据类型(通常为4位)和一种计算数据类型(通常为BFloat16)。实际操作中,每当使用QLORA权重张量时,将其反量化为BFloat16,然后进行16位矩阵乘法。

论文提出的**QLORA(Quantized Low-Rank Adapter)**通过以下创新技术解决了这一问题:

- 4位NormalFloat(NF4)量化

设计了一种信息论最优的4位数据类型,专门针对正态分布的模型权重,显著减少内存占用的同时保持精度。 - 双重量化(Double Quantization)

对量化常数进行二次量化,进一步降低内存消耗(例如,65B模型节省约3GB内存)。 - 分页优化器(Paged Optimizers)

利用NVIDIA统一内存技术动态管理优化器状态,避免梯度检查点导致的内存峰值,确保训练过程稳定。

4位正态浮点(NF4)量化

正态浮点(NF)数据类型基于分位数量化 [15],这是一种信息论最优的数据类型,确保每个量化bin包含相同数量的输入值。分位数量化通过经验累积分布函数估计输入张量的分位数。

分位数量化的主要局限是分位数估计过程计算量大,因此通常使用快速近似算法(如SRAM分位数 [15])。由于近似误差,该数据类型对异常值的量化误差较大,而异常值往往是最重要的值。

当输入张量服从固定分布(可通过量化常数缩放)时,分位数估计的计算成本和近似误差可以被避免。预训练神经网络的权重通常服从零均值正态分布(标准差为σ,见附录F),因此可通过缩放σ使其分布适配数据类型范围(如[-1,1])。此时,数据类型和神经网络权重的分位数均可归一化到该范围。

针对零均值正态分布的信息论最优k位数据类型的构造步骤如下:

- 估计标准正态分布 的 个分位数,得到k位分位数量化数据类型。

- 将数据类型值归一化到[-1,1]范围。

- 通过绝对最大值归一化输入权重张量,使其范围与数据类型匹配。

为确保离散零点和充分利用k位,设计了非对称数据类型:分别估计正负区间的分位数(负区间 个,正区间 个),合并后去除重复零点。这种数据类型称为**k位正态浮点(NFk)**,因为它对零均值正态分布数据是信息论最优的。具体数值见附录E。

双重量化(Double Quantization)

引入**双重量化(DQ)**,即对量化常数进行二次量化以进一步节省内存。虽然小分块(如64)能提高4位量化精度,但会增加内存开销。例如,使用32位常数和分块大小64时,量化常数平均增加 位/参数。

双重量化将第一级量化的常数 作为第二级量化的输入,得到量化后的常数 和第二级量化常数 。第二级量化使用分块大小256的8位浮点(无性能损失)。由于 为正数,量化前先减去均值以中心化数据。对于分块大小64,这一优化将内存占用从0.5位/参数降至 位/参数,节省0.373位/参数。

分页优化器(Paged Optimizers)

分页优化器利用NVIDIA统一内存技术,自动在CPU和GPU之间进行页交换,避免因梯度检查点导致的内存峰值引发的OOM错误。优化器状态存储在分页内存中,当GPU内存不足时自动迁移到CPU RAM,更新时再加载回GPU。

QLORA定义

基于上述组件,QLORA对量化基础模型中的单个线性层和单个LoRA适配器的定义如下:

其中 定义为:

对 使用NF4,对 使用FP8,分块大小分别为64和256。参数更新仅涉及适配器权重 的梯度 ,而无需计算4位权重 的梯度。梯度计算通过反量化 到 进行。

关键技术总结

- NF4量化:针对正态分布数据优化的4位数据类型,减少内存且保持精度。

- 双重量化:对量化常数二次量化,进一步节省内存。

- 分页优化器:动态管理内存,避免训练时的内存峰值。

- 全层适配器:在所有网络层添加LoRA适配器,恢复全精度性能。

核心贡献

- 内存效率:将65B模型的微调内存需求从>780GB降至<48GB,首次实现单GPU(48GB)训练。

- 性能保持:通过在所有网络层添加低秩适配器(LoRA),QLORA在多个基准(如Vicuna、MMLU)上达到了与全精度微调相当的性能。

- 实用价值:开源代码和模型(包括7B/13B/33B/65B参数版本),推动大模型微调的普及,缩小了学术研究与工业界的资源差距。

应用意义

QLORA使得大模型微调更易于访问,为个性化AI助手、多语言模型开发等应用提供了可行方案,同时为研究人员探索模型能力边界提供了高效工具。

LoRA vs AdaLoRA vs QLoRA

LoRA、QLoRA和ADALORA三种方法在技术原理、性能表现、资源效率及适用场景等维度的对比分析

技术原理与核心创新

1. LoRA(Low-Rank Adaptation)

- 核心思想:通过低秩矩阵分解模拟模型参数更新,将原始权重矩阵 分解为两个低秩矩阵 和 的乘积(),仅训练这两个矩阵。

- 技术优势:

- 参数高效:可训练参数仅为原始模型的 (如GPT-3 175B模型从3.5万亿参数降至3.5亿)。

- 零推理延迟:训练后将 合并到原始权重,推理时无需额外计算。

- 兼容性强:支持多种模型架构(如Transformer、BERT),适用于监督/无监督任务。

- 局限性:

- 固定秩假设:秩 需手动设定,无法动态适应任务复杂度。

- 仅微调注意力模块:忽略前馈网络(FFN)的优化潜力。

2. QLoRA(Quantized Low-Rank Adapter)

- 核心思想:在LoRA基础上引入4位量化,将预训练模型权重量化为4位NormalFloat(NF4),并通过双重量化进一步压缩量化常数。

- 技术优势:

- 极致内存优化:65B参数模型微调内存从780GB降至48GB(单卡即可训练),移动端推理内存减少88%。

- 精度保持:NF4量化在信息论上对正态分布权重最优,实验显示其性能接近16位全微调。

- 分页优化器:利用NVIDIA统一内存管理内存峰值,训练速度损失仅12%。

- 局限性:

- 量化误差:极端压缩可能导致模型性能下降,需通过数据集质量补偿。

- 硬件依赖:需支持4位计算的GPU(如A100、H100)。

3. ADALORA(Adaptive LoRA)

- 核心思想:动态调整低秩矩阵的秩 ,根据权重矩阵的重要性评分(如梯度幅度、奇异值)分配参数预算。

- 技术优势:

- 动态秩分配:关键权重矩阵分配高秩以捕捉细节,非关键矩阵降低秩以减少冗余。

- 鲁棒性提升:在RTE数据集上,0.3M参数预算下性能比基线高1.8%。

- 多任务适配:通过元学习或注意力机制自动适应任务变化。

- 局限性:

- 计算开销:动态调整秩需额外计算(如SVD分解),训练时间增加约10%~20%。

- 超参数敏感:重要性评分计算需谨慎设计,否则可能引入噪声。

性能对比与实验结果

| 指标 | LoRA | QLoRA | ADALORA |

|---|---|---|---|

| 可训练参数 | 原始模型的 | 与LoRA相当,但量化后存储更小 | 动态调整,平均参数约为LoRA的50%~150% |

| 微调内存 | 减少3倍(如GPT-3 175B从780GB降至260GB) | 减少16倍(65B模型从780GB降至48GB) | 与LoRA相当,但训练时需额外计算资源 |

| 推理延迟 | 无增加(合并权重后) | 无增加(量化后可能轻微加速) | 无增加(动态调整仅在训练时) |

| 典型性能 | GLUE基准接近全微调 | MMLU基准恢复16位性能,Vicuna达ChatGPT 99.3% | 复杂任务(如数学推理)提升5%~10% |

| 硬件需求 | 消费级GPU(如RTX 4090) | 支持4位计算的GPU(如A100) | 高端GPU(如H100) |

具体案例

- LoRA:在卫星遥感图像检测任务中,仅微调12.4%参数即可达到全微調97%~100%的性能。

- QLoRA:在Llama-3-400B微调中,量化常数内存从12.8MB降至3.2MB,移动端推理速度达45 tokens/s。

- ADALORA:在数学推理任务中,秩动态调整使模型性能提升4%,优于LoRA和TAIA。

资源效率与适用场景

1. 资源效率

- 内存占用:QLoRA > ADALORA > LoRA(量化后QLoRA最小)。

- 计算成本:ADALORA > LoRA > QLoRA(量化加速计算)。

- 训练速度:QLoRA(量化加速)> LoRA > ADALORA(动态调整开销)。

2. 适用场景

| 方法 | 适用场景 | 典型案例 |

|---|---|---|

| LoRA | 资源有限的微调(如个人电脑、边缘设备) | 卫星遥感图像处理、小数据集指令微调 |

| QLoRA | 内存受限的环境(如移动端、嵌入式设备)或需快速部署的大模型 | 手机端70B模型推理、单卡微调65B模型 |

| ADALORA | 复杂任务(如多模态、数学推理)或数据分布动态变化的场景 | 医疗诊断、金融风险预测、动态多任务处理 |

优缺点总结

| 方法 | 优点 | 缺点 |

|---|---|---|

| LoRA | 参数高效、零推理延迟、兼容性强 | 固定秩、忽略FFN模块、超参数敏感 |

| QLoRA | 极致内存压缩、支持单卡训练大模型、移动端友好 | 量化误差、硬件依赖、数据集质量要求高 |

| ADALORA | 动态适应任务、复杂场景性能优、鲁棒性强 | 计算开销大、超参数设计复杂、训练时间较长 |

发展脉络与选择建议

- 技术演进:

- LoRA(2021)是参数高效微调的基础,QLoRA(2024)通过量化进一步优化内存,ADALORA(2023)引入动态机制提升灵活性。

- 未来方向:结合量化与动态调整(如Quantized ADALORA)、跨模态任务适配。

- 选择建议:

- 资源有限:优先选LoRA或QLoRA,QLoRA在内存敏感场景更优。

- 复杂任务:ADALORA适合动态调整需求,但需权衡计算资源。

- 部署需求:QLoRA在移动端或边缘设备表现最佳。

开源支持与工具链

- LoRA:Hugging Face

peft库、微软LoRA实现。 - QLoRA:GitHub QLoRA,支持Llama、GPT-NeoX等模型。

- ADALORA:GitHub AdaLoRA,需手动配置动态秩参数。

代码示例

以Qwen/Qwen2.5-VL-7B-Instruct为例,实现多模态大模型LoRA微调的完整流程指南。

环境准备与工具选择

-

微调框架

推荐使用LLaMA-Factory,该框架原生支持Qwen系列模型的LoRA微调,且提供多模态数据处理接口。安装命令:# 创建conda虚拟环境conda create -n qwen_vl python=3.10 -yconda activate qwen_vl# 安装基础依赖git clone <https://github.com/hiyouga/LLaMA-Factory.git>cd LLaMA-Factorypip install -e ".[torch,metrics,vl]"# 安装PyTorchpip install torch==2.2.2 torchvision==0.17.2 torchaudio==2.2.2 --index-url <https://download.pytorch.org/whl/cu118># 安装多模态处理工具pip install qwen-vl-utils pillow==11.0.0 -

硬件配置

• 显存需求:至少24GB(建议A100/A800显卡) • 内存需求:32GB以上(处理高分辨率图像时需动态扩展交换空间)

数据处理流程

-

多模态数据格式数据集需包含图像URL/Base64编码和文本指令,示例结构:

{ "conversations": [ { "role": "user", "content": [ {"type": "text", "text": "描述这张图片中的医疗设备"}, {"type": "image", "image": "data:image/jpeg;base64,/9j/4AA..."} ] }, { "role": "assistant", "content": "这是CT扫描仪,主要用于..." } ]} -

预处理脚本

使用模型自带的Processor处理视觉输入:# data_preprocess.pyimport pandas as pdimport jsonfrom pathlib import Pathdef convert_to_vl_format(csv_path, output_dir): df = pd.read_csv(csv_path) dataset = [] for idx, row in df.iterrows(): image_path = Path(row['image_path']).name sample = { "id": f"identity_{idx+1}", "conversations": [ { "role": "user", "content": [ {"type": "text", "text": "描述这张图片"}, {"type": "image", "image": f"data/{image_path}"} ] }, { "role": "assistant", "content": row['caption'] } ] } dataset.append(sample) with open(f"{output_dir}/dataset.json", "w") as f: json.dump(dataset, f, ensure_ascii=False, indent=2)if **name** == "**main**": convert_to_vl_format("coco_train.csv", "data/multimodal_dataset") ``````plaintext from transformers import Qwen2_5_VLProcessorprocessor = Qwen2_5_VLProcessor.from_pretrained("Qwen/Qwen2.5-VL-7B-Instruct")inputs = processor( text=[formatted_text], images=image_tensors, videos=video_tensors, return_tensors="pt")

LoRA微调配置

-

配置文件修改在

examples/train_qlora目录下创建qwen2.5_vl_lora.yaml,关键参数:# qwen2.5_vl_lora.yamlmodel_name_or_path:Qwen/Qwen2.5-VL-7B-Instructquantization_bit:4finetuning_type:loralora_target:[q_proj,v_proj,vision_mlp]dataset_dir:data/multimodal_datasettemplate:qwen_vlvision_config:naive_dynamic_resolution:truemax_image_size:1024training_args:output_dir:outputs/qwen2.5_vl_loraper_device_train_batch_size:2gradient_accumulation_steps:8learning_rate:2e-5num_train_epochs:3fp16:truelogging_steps:10save_strategy:stepssave_steps:1000 -

视觉编码器适配需启用动态分辨率支持:

vision_config: naive_dynamic_resolution: true max_image_size: 1024

启动微调训练

# train.shCUDA_VISIBLE_DEVICES=0 python src/train_bash.py \ --config configs/qwen2.5_vl_lora.yaml \ --stage sft \ --do_train \ --use_llama_prompt

“

参数说明:

per_device_train_batch_size:根据显存调整(4GB显存/样本)gradient_accumulation_steps:累计梯度降低显存峰值vision_mlp:视觉编码器的适配层

关键技术点

- 动态分辨率支持模型通过Naive Dynamic Resolution技术处理任意尺寸图像,无需分割裁剪,保留原始视觉信息。

- 多模态位置编码

采用M-ROPE(Multimodal Rotary Position Embedding)同时编码文本、图像、视频的时空关系。 - 混合精度训练

使用--fp16参数激活混合精度训练,相比FP32节省40%显存。

验证与部署

-

推理测试脚本

# inference.pyfrom transformers import Qwen2_5_VLProcessorfrom peft import PeftModelimport torch# 加载微调后的模型base_model = "Qwen/Qwen2.5-VL-7B-Instruct"lora_path = "outputs/qwen2.5_vl_lora"processor = Qwen2_5_VLProcessor.from_pretrained(base_model)model = PeftModel.from_pretrained(base_model, lora_path).to('cuda')# 处理多模态输入image_path = "test_image.jpg"prompt = [ {"type": "text", "text": "描述这张图片中的医疗设备"}, {"type": "image", "image": image_path}]inputs = processor(text=prompt, images=image_path, return_tensors="pt").to('cuda')# 生成响应with torch.inference_mode(): outputs = model.generate(**inputs, max_new_tokens=512)response = processor.decode(outputs[0], skip_special_tokens=True)print(response) -

服务化部署

可封装为OpenAI兼容API:from fastapi import FastAPIapp = FastAPI()@app.post("/v1/chat/completions")async def chat_completion(request: dict): # 消息格式转换逻辑 return {"choices": [{"message": generated_text}]}

性能优化建议

-

显存不足解决方案

• 启用4-bit量化:--quantization_bit 4

• 使用梯度检查点:--gradient_checkpointing true -

多卡训练配置

torchrun --nproc_per_node=4 src/train_bash.py \ # ...其他参数保持不变

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)