炸裂!智谱AI开源GLM-4.6V多模态大模型,能看能想还能执行,本地部署9B轻量版来了!

智谱AI开源多模态大模型GLM-4.6V系列,包含106B参数的云端高性能版和9B参数的轻量本地版。新模型支持128K tokens上下文窗口,原生集成Function Calling能力,可理解图像并执行复杂任务。GLM-4.6V-Flash轻量版特别适合个人开发者和边缘设备部署。用户可通过ModelScope平台免费体验该模型,探索智能客服、AI编程等应用场景。

摘要

就在近日,智谱AI(Zhipu AI / Z.ai)正式开源了其最新一代多模态大模型 GLM-4.6V 系列!该系列包含两款模型:106B参数的云端高性能版 GLM-4.6V,以及 仅9B参数、支持本地部署的轻量版 GLM-4.6V-Flash。新模型不仅支持长达 128K tokens 的上下文窗口,更原生集成了 Function Calling 能力,能够理解图像、执行工具调用,并完成复杂多步任务。本文将带你快速了解 GLM-4.6V 的核心亮点、适用场景及如何在 ModelScope 上体验这一强大模型。

一、GLM-4.6V 是什么?

GLM-4.6V 是智谱AI推出的 多模态大语言模型(Multimodal LLM),属于其广受关注的 GLM-4 系列。与纯文本模型不同,GLM-4.6V 能够同时理解 文本与图像信息,并在此基础上进行推理、规划和执行操作。

目前,该系列包含两个版本:

- GLM-4.6V(106B-A12B):面向云端部署和高性能计算集群,适合需要极致性能的企业级应用。

- GLM-4.6V-Flash(9B):轻量级版本,参数量仅为9B,支持本地部署,特别适合对延迟敏感或资源受限的场景,如个人开发者、边缘设备等。

二、三大核心亮点

1. 超长上下文 + SOTA 视觉理解能力

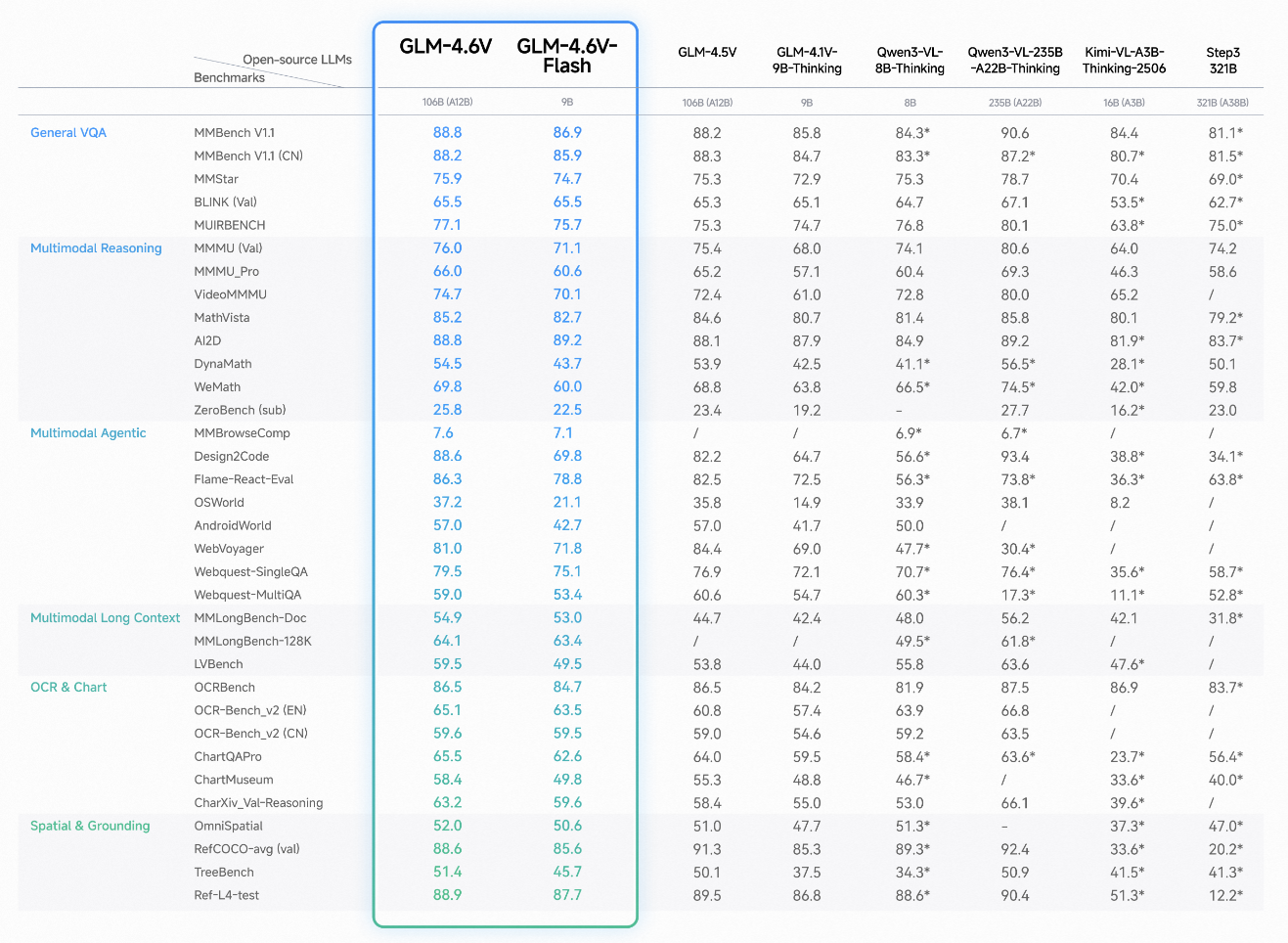

GLM-4.6V 在训练中将上下文窗口扩展至 128K tokens,这意味着它能处理超长文档、复杂对话历史或高分辨率图像描述。同时,在相同参数规模下,其视觉理解能力达到 当前最优(SOTA)水平。

2. 原生支持 Function Calling

这是 GLM-4.6V 的一大突破:首次在模型架构中直接集成 Function Calling 能力。这意味着模型不仅能“看”和“说”,还能主动调用外部工具(如搜索、计算、API等),实现真正的“能想还能做”的智能体行为。

3. 轻量版可本地运行,开发者友好

对于普通开发者或中小团队,GLM-4.6V-Flash(9B) 提供了一个极具吸引力的选择。它体积小、推理快,可在消费级 GPU 上运行,大大降低了多模态AI的使用门槛。

三、如何体验?

你可以在 魔搭(ModelScope)平台 上免费体验 GLM-4.6V 系列模型。访问以下链接即可查看模型详情、在线推理、下载权重或部署服务:

👉 https://modelscope.cn/collections/GLM-46V-37fabc27818446

ModelScope 提供了一站式的模型探索、训练、部署与应用服务,是中文社区最活跃的模型开放平台之一。

- GLM-4.6V 博客:https://z.ai/blog/glm-4.6v

- 论文:https://huggingface.co/papers/2507.01006

- GitHub 仓库:https://github.com/zai-org/GLM-V

- 在线 Demo:https://chat.z.ai/

- API 访问:ZhipuAI 开放平台

- 桌面助手应用:https://huggingface.co/spaces/zai-org/GLM-4.5V-Demo-App

结语

GLM-4.6V 系列的开源,标志着多模态大模型正从“实验室”走向“开发者桌面”。无论是构建智能客服、AI编程助手,还是开发能理解图文的智能终端,GLM-4.6V 都提供了强大而灵活的底层支持。

如果你对多模态AI、智能体开发或本地部署大模型感兴趣,不妨立即去 ModelScope 试试 GLM-4.6V-Flash,说不定你的下一个爆款项目就从这里开始!

祝你编码愉快,AI玩得开心!😊

标签:#多模态大模型 #GLM4 #ModelScope

版权声明:本文为原创内容,版权归作者所有,转载需注明出处。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)