跨平台高效开源文件同步工具解析与实战

在多操作系统共存的企业IT环境中,跨平台文件同步工具已成为保障数据一致性与高可用性的关键技术。这类工具不仅支持Windows与Linux系统之间的无缝文件传输,还具备高效的增量同步、权限保留与网络优化等核心功能。其应用场景广泛,涵盖跨系统数据备份、服务器迁移、分布式部署及远程协作开发等关键业务流程。选择一款兼容性强、性能稳定的开源同步工具,如rsync,不仅能降低运维成本,还能提升系统可靠性与扩展

简介:该工具是一款支持Windows与Linux系统的开源文件同步解决方案,具备操作简便与高效处理能力,适用于多服务器或混合操作系统环境下的数据一致性维护。通过优化的同步算法,它可快速完成大量文件(如百万级小文件)的同步任务,并支持单向与双向同步模式。工具内置rsync技术,仅传输文件变化部分,节省带宽并提升效率。服务端与客户端架构便于用户灵活配置同步任务,适合网站备份、数据迁移及服务器集群维护等场景。依托开源社区,工具具备持续更新与完善的能力。

1. 跨平台文件同步工具简介

在多操作系统共存的企业IT环境中,跨平台文件同步工具已成为保障数据一致性与高可用性的关键技术。这类工具不仅支持Windows与Linux系统之间的无缝文件传输,还具备高效的增量同步、权限保留与网络优化等核心功能。其应用场景广泛,涵盖跨系统数据备份、服务器迁移、分布式部署及远程协作开发等关键业务流程。选择一款兼容性强、性能稳定的开源同步工具,如rsync,不仅能降低运维成本,还能提升系统可靠性与扩展性,为后续深入学习打下坚实基础。

2. rsync同步机制解析

rsync 是 Linux 系统中最常用的文件同步工具之一,其高效、稳定、可扩展的特性使其广泛应用于本地备份、远程同步、自动化部署等多个场景。本章将深入解析 rsync 的同步机制,包括其协议结构、增量传输原理、跨平台实现方式及其典型使用场景。通过本章内容,读者将能够掌握 rsync 的核心原理,并具备在不同操作系统环境中进行高效文件同步的能力。

2.1 rsync协议与工作原理

rsync 的核心在于其高效的同步协议,该协议通过差分传输机制大幅减少网络带宽的消耗。其工作流程主要包括连接建立、文件列表生成、差分计算与数据传输四个阶段。

2.1.1 rsync的增量传输机制

rsync 的增量传输(delta transfer)机制是其高效同步的关键。它不会每次都传输整个文件,而是仅传输文件发生变化的部分。这种机制大大减少了数据传输量,特别是在网络带宽受限的环境中,优势尤为明显。

工作流程如下:

- 文件指纹生成 :

rsync在接收端(receiver)生成目标文件的哈希指纹(checksum)。 - 发送端比对 :发送端(sender)将源文件按固定大小(block size)分割为多个块,并计算每个块的弱校验(rolling checksum)和强校验(MD4/MD5)。

- 差异检测 :发送端将每个块的校验值与接收端的指纹进行比对,找出匹配的块。

- 差分数据发送 :未匹配的块和差异信息被发送到接收端。

- 本地重建 :接收端根据接收到的差分信息和本地已有的块重建完整文件。

示例代码:

rsync -avz --partial source/ user@remote:/path/to/dest/

-a:归档模式,保留权限、时间戳、符号链接等属性。-v:详细输出。-z:压缩传输。--partial:保留中断传输的文件,便于后续恢复。

代码逻辑分析:

source/:表示同步源目录,注意斜杠/表示同步目录内容而非目录本身。user@remote:/path/to/dest/:目标地址,格式为用户@主机:路径。-avz是常见的组合参数,适用于大多数同步场景。--partial在断点续传中非常有用,尤其是在传输大文件时。

参数说明:

| 参数 | 含义 |

|---|---|

| -a | 归档模式,等价于 -rlptgoD ,保留所有文件属性 |

| -v | 显示详细同步信息 |

| -z | 使用压缩传输数据 |

| –partial | 中断后保留部分文件,用于续传 |

2.1.2 基于差分算法的数据同步流程

rsync 使用的差分算法称为 rsync 算法 ,由 Andrew Tridgell 博士提出。其核心思想是:在不完全传输整个文件的前提下,通过计算源文件与目标文件的差异部分进行传输。

差分算法流程图(Mermaid):

graph TD

A[源文件分块] --> B[计算每个块的弱校验和强校验]

B --> C[发送校验值到接收端]

C --> D[接收端查找匹配块]

D --> E{是否匹配?}

E -->|是| F[发送块索引]

E -->|否| G[发送实际数据]

F & G --> H[接收端重建文件]

逻辑分析:

- 该流程图清晰展示了rsync差分算法的执行路径。

- 源文件在发送端被分割成固定大小的块(默认 700 字节),每个块生成两个校验值。

- 接收端根据这些校验值查找本地是否有相同块,若有则只需传输索引,否则传输实际数据。

- 最终接收端根据索引和新数据重建文件,实现高效同步。

2.1.3 校验机制与数据完整性保障

为确保数据传输的完整性, rsync 在同步完成后会对文件进行最终校验,确保源与目标文件一致。

主要校验机制包括:

- 文件属性校验 :包括文件大小、修改时间、权限等。

- 内容校验 :通过 MD4/MD5 对整个文件进行最终哈希计算。

- 同步确认机制 :在同步完成后,

rsync会输出同步结果,包括传输的文件数、字节数、耗时等。

示例命令:

rsync -avh --checksum source/ user@remote:/path/to/dest/

--checksum:强制对所有文件进行内容校验,即使修改时间与大小一致也进行比对。

代码逻辑分析:

-a:归档模式,保留所有属性。-v:显示详细输出。-h:以人类可读的方式显示大小。--checksum:启用内容校验,适用于需要确保数据一致性的场景。

2.2 rsync在Windows与Linux中的实现差异

虽然 rsync 最初是为 Linux 设计的,但其功能已通过兼容层在 Windows 系统中得以实现。然而,由于系统架构和路径格式的差异, rsync 在两个平台上的实现方式和配置方法有所不同。

2.2.1 Windows平台下的rsync兼容层(如Cygwin)

在 Windows 上使用 rsync 需借助兼容层,最常见的是 Cygwin 。Cygwin 提供了一个类 Unix 的运行环境,允许 Windows 用户运行原生的 Linux 工具。

安装步骤:

- 下载并运行 Cygwin 安装程序。

- 在安装过程中选择

rsync、openssh、perl等包。 - 安装完成后,在 Cygwin 终端中使用

rsync命令。

示例命令:

rsync -avz /cygdrive/c/Users/Admin/source/ user@linuxserver:/home/user/dest/

/cygdrive/c/...:表示 Windows 的 C 盘路径,在 Cygwin 中以类 Unix 方式访问。

代码逻辑分析:

- Cygwin 将 Windows 路径映射为

/cygdrive/盘符/路径的形式。 - 所有操作需在 Cygwin 终端中进行。

- 若需远程同步,需配置 SSH 服务(如 OpenSSH)。

2.2.2 Linux原生rsync的配置与优化

在 Linux 平台上, rsync 是原生支持的工具,安装和使用非常方便。许多发行版(如 Ubuntu、CentOS)默认已安装 rsync ,如未安装可使用以下命令安装:

sudo apt install rsync # Debian/Ubuntu

sudo yum install rsync # CentOS/RHEL

配置优化建议:

- 使用 rsync daemon 模式:

可通过配置 /etc/rsyncd.conf 文件启用守护进程模式,提供更高效的远程同步服务。

ini [backup] path = /data/backup comment = Backup Share read only = no list = yes uid = nobody gid = nogroup

- 启用压缩传输:

bash rsync -avz source/ user@remote::backup

- 限制带宽:

bash rsync -avz --bwlimit=1000 source/ user@remote:/path/to/dest/

- --bwlimit=1000 :限制带宽为 1000 KB/s。

2.2.3 跨系统路径处理与编码转换

在跨平台同步过程中,路径格式与编码方式是常见的问题。Windows 使用 \ 作为路径分隔符,而 Linux 使用 / ;此外,Windows 默认使用 UTF-16 编码,而 Linux 通常使用 UTF-8。

路径转换规则:

| 平台 | 路径分隔符 | 示例路径 |

|---|---|---|

| Windows | \ |

C:\Users\Admin\file.txt |

| Linux | / |

/home/user/file.txt |

编码转换建议:

- 使用

--iconv参数指定编码转换:

rsync -avh --iconv=utf-8,gbk source/ user@remote:/path/to/dest/

- 该参数表示从 UTF-8 转换为 GBK 编码,适用于中文路径处理。

2.3 rsync的典型使用场景与命令实践

rsync 的使用场景非常广泛,涵盖本地备份、远程同步、自动化脚本编写等多个方面。本节将通过具体命令示例展示其在不同场景下的使用方式。

2.3.1 本地文件同步

本地同步是最基础的用法,适用于备份、归档等场景。

示例命令:

rsync -avh /home/user/docs/ /backup/docs/

- 同步

/home/user/docs/到/backup/docs/。 -a保留权限和时间戳。-v显示进度。-h显示可读性大小。

优点:

- 速度快,无需网络传输。

- 支持硬链接与符号链接复制。

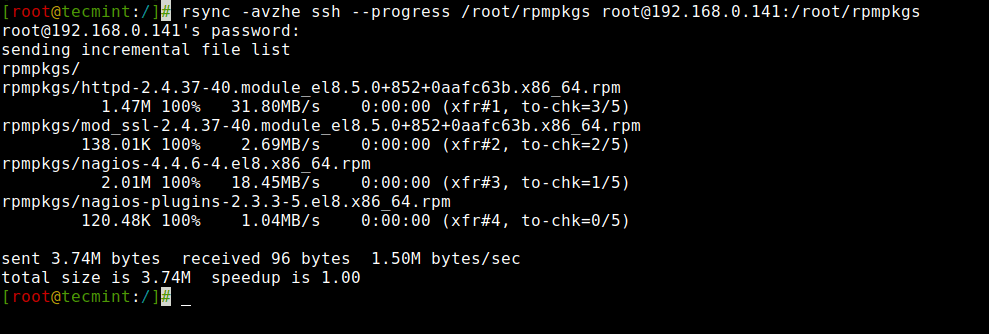

2.3.2 基于SSH的远程同步

rsync 支持通过 SSH 协议进行安全的远程同步。

示例命令:

rsync -avz -e ssh /home/user/data/ user@remote:/home/user/backup/

-e ssh:指定使用 SSH 作为传输协议。user@remote:远程主机的登录信息。

优点:

- 数据传输加密,安全性高。

- 支持密钥登录,自动化操作更便捷。

2.3.3 定时任务与自动化脚本编写

通过 cron 或脚本可以实现定时同步,适用于数据备份、日志归档等任务。

示例:创建一个同步脚本 sync.sh :

#!/bin/bash

LOGFILE="/var/log/rsync.log"

DATE=$(date +"%Y-%m-%d %T")

echo "[$DATE] Starting rsync..." >> $LOGFILE

rsync -avz --delete /data/ user@backup:/data/ >> $LOGFILE 2>&1

echo "[$DATE] Sync completed." >> $LOGFILE

配置定时任务(cron):

crontab -e

添加如下行:

0 2 * * * /path/to/sync.sh

- 每天凌晨 2 点执行脚本。

小结

本章详细解析了 rsync 的同步机制、跨平台实现差异及其典型使用场景。通过对 rsync 的协议结构、差分算法、路径处理、编码转换等内容的分析,读者可以深入理解其内部运行机制。此外,结合实际命令示例和流程图,帮助读者掌握 rsync 的使用技巧与优化方法。下一章将围绕“单向与双向同步”的实现原理展开,进一步探讨如何在不同场景中实现高效的数据同步策略。

3. 单向与双向同步实现原理

现代IT系统中,文件同步的需求不仅限于数据的简单复制,而是涉及到数据流向、冲突处理和一致性保障等复杂场景。根据数据同步的方向性,我们可以将同步策略划分为 单向同步 和 双向同步 两种类型。本章将深入剖析这两种同步方式的技术实现原理、典型应用场景、实现方法及运维策略,帮助读者构建系统性的同步机制认知。

3.1 单向同步的技术流程与应用场景

单向同步是指数据从一个源头(源端)单向复制到一个或多个目标位置(目标端)的过程。这种模式在备份、镜像和分发等场景中广泛使用,具有高效、稳定、易于管理的特点。

3.1.1 主备服务器数据镜像同步

主备服务器架构是企业级系统中常见的高可用性部署方式。通过单向同步,可以将主服务器上的数据实时或定期复制到备用服务器,确保在主服务器发生故障时,备服务器可以快速接管服务。

实现示例:使用 rsync 同步主备服务器

rsync -avz --delete /data/ user@backup:/backup/

- 参数说明 :

-a:归档模式,保留文件属性;-v:显示同步过程;-z:压缩传输;--delete:删除目标中源端不存在的文件,保持一致性。

逻辑分析:

rsync扫描/data/目录下的所有文件;- 建立与远程服务器

backup的连接; - 比较源与目标文件的哈希值,仅传输差异部分;

- 若启用

--delete,则删除目标中多余的文件,实现镜像效果; - 同步完成后断开连接。

应用场景:

- 数据中心主备容灾;

- 网站内容静态资源的同步;

- 数据库的热备机制。

3.1.2 只读客户端的文件分发

在大规模部署中,常常需要将统一的配置文件、脚本或程序分发到多个只读客户端。单向同步非常适合这种“写一次,读多次”的场景。

示例:使用 rsync 分发配置文件

rsync -avz /etc/app_config/ user@client1:/etc/app_config/

rsync -avz /etc/app_config/ user@client2:/etc/app_config/

优化建议:

- 可结合

xargs或parallel实现并行推送; - 使用 SSH 密钥免密登录提升效率;

- 利用

--exclude参数排除临时文件或日志文件。

3.1.3 使用 rsync + inotify 实现自动触发同步

为了实现更实时的同步,可以结合 inotify 文件系统监控工具,在文件变化时自动触发 rsync 同步操作。

安装与配置步骤:

# 安装 inotify-tools

sudo apt install inotify-tools

# 编写监控脚本 sync_watcher.sh

#!/bin/bash

SRC_DIR="/var/www/html"

DEST_DIR="user@backup:/var/www/html"

while inotifywait -r -e modify,create,delete $SRC_DIR; do

rsync -avz --delete $SRC_DIR $DEST_DIR

done

参数说明:

inotifywait:监听文件系统事件;-r:递归监听子目录;-e:监听的事件类型(修改、创建、删除);rsync同步过程如前所述。

流程图说明:

graph TD

A[文件修改事件] --> B{inotify触发}

B --> C[启动 rsync 同步]

C --> D[比较差异]

D --> E[传输变化数据]

E --> F[同步完成]

应用优势:

- 准实时同步,减少延迟;

- 避免轮询方式的资源浪费;

- 提高运维响应速度。

3.2 双向同步的挑战与解决方案

双向同步是指两个节点之间的数据相互同步,任何一方的变更都会反映到对方。相比单向同步,双向同步面临 数据冲突 、 同步顺序混乱 、 一致性保障 等挑战。

3.2.1 冲突检测与解决机制

在双向同步中,如果两个节点同时修改了同一个文件,就会发生冲突。解决冲突的关键在于 冲突检测机制 与 解决策略 。

常见冲突类型:

| 冲突类型 | 描述 | 解决方式 |

|---|---|---|

| 文件内容冲突 | 同一文件被两个节点修改 | 手动合并或使用版本控制系统 |

| 文件删除冲突 | 一个节点删除文件,另一个节点修改了它 | 保留修改后的文件或标记冲突 |

| 文件重命名冲突 | 两个节点重命名文件为相同名称 | 提示冲突并让用户选择处理 |

冲突解决策略:

- 时间戳优先 :保留时间较新的版本;

- 版本控制 :使用 Git 等版本控制系统记录变更;

- 人工干预 :标记冲突并由运维人员手动处理;

- 自动合并 :使用工具(如

unison)尝试自动合并。

3.2.2 使用 unison 或 lsyncd 实现双向同步

使用 Unison 实现双向同步

Unison 是一个功能强大的双向同步工具,支持跨平台使用,并提供图形界面与命令行两种操作方式。

示例命令:

unison /path/to/local root@remote:/path/to/remote

参数说明:

- 支持双向扫描、差异比较;

- 自动检测冲突并提示用户处理;

- 支持 SSH 加密传输;

- 可配置同步策略文件(

.prf)定义同步规则。

同步流程图:

graph LR

A[本地与远程扫描文件] --> B[比较文件差异]

B --> C{是否存在冲突?}

C -->|是| D[提示用户解决冲突]

C -->|否| E[执行同步]

E --> F[更新本地与远程]

使用 Lsyncd 实现双向同步

Lsyncd 是基于 inotify 的实时同步工具,适合用于监控文件系统变化并触发同步任务。

示例配置文件 /etc/lsyncd.conf :

settings = {

logfile = "/var/log/lsyncd.log",

statusFile = "/tmp/lsyncd.status"

}

sync {

default.rsync,

source = "/data/local",

target = "user@remote:/data/remote",

rsync = {

archive = true,

compress = true,

delete = true

}

}

特点:

- 实时监控,自动同步;

- 支持多种同步模式(rsync、ssh、直接复制);

- 日志记录便于运维追踪。

3.2.3 数据一致性保障策略

在双向同步中,数据一致性是核心挑战。为确保数据一致,可采用以下策略:

- 事务机制 :将同步操作封装为事务,失败则回滚;

- 版本快照 :在每次同步前保留快照,便于回溯;

- 日志记录 :详细记录每次同步操作,便于分析与恢复;

- 网络重试机制 :在网络波动时自动重试;

- 锁机制 :防止两个节点同时修改同一文件。

3.3 同步过程中的日志记录与异常处理

无论单向还是双向同步,日志记录和异常处理都是保障系统稳定运行的重要环节。合理的日志策略可以帮助快速定位问题,而完善的异常处理机制则能提高同步的健壮性。

3.3.1 日志级别与输出格式

在同步工具中,通常支持多种日志级别(如 debug、info、warn、error),以便运维人员根据需求选择合适的日志输出。

rsync 日志配置示例:

rsync -avz --log-file=/var/log/rsync.log /src/ /dest/

--log-file:指定日志文件路径;- 可结合

--verbose或--quiet控制日志输出量。

日志内容示例:

2025/04/05 10:00:00 [rsyncd] building file list

2025/04/05 10:00:01 [rsyncd] sent 12345 bytes received 6789 bytes

2025/04/05 10:00:02 [rsyncd] total size is 1048576 speedup is 54.32

日志分析建议:

- 使用

grep过滤特定关键字(如 error、fail); - 使用

logrotate管理日志文件大小与保留周期; - 集中日志系统(如 ELK、Graylog)进行统一管理。

3.3.2 同步失败的重试机制

同步失败可能由网络中断、权限问题或文件锁定等原因引起。通过配置重试机制可以提高同步的容错能力。

使用 shell 实现重试机制:

MAX_RETRY=3

RETRY=0

while [ $RETRY -lt $MAX_RETRY ]; do

rsync -avz /src/ user@remote:/dest/ && break

let RETRY=RETRY+1

sleep 10

done

if [ $RETRY -eq $MAX_RETRY ]; then

echo "同步失败,已达到最大重试次数" | mail -s "同步失败" admin@example.com

fi

参数说明:

MAX_RETRY:最大重试次数;sleep 10:每次失败后等待10秒;mail:发送失败通知邮件。

3.3.3 告警通知与运维监控集成

为了及时发现同步异常,可将同步过程与告警系统集成。

集成方式:

- 邮件通知 :使用

mail或mutt发送告警邮件; - Slack / Webhook :通过

curl调用 Webhook 推送告警; - Prometheus + Alertmanager :采集同步状态指标并触发告警;

- Zabbix / Nagios :设置监控项检测同步状态。

示例:同步失败后调用 Slack Webhook:

if ! rsync -avz /src/ user@remote:/dest/; then

curl -X POST -H 'Content-type: application/json' \

--data '{"text":"同步失败,请检查网络或权限"}' \

https://hooks.slack.com/services/your/webhook/url

fi

优势:

- 实时通知异常;

- 提高故障响应速度;

- 与现有运维体系无缝集成。

4. 高效增量同步技术实现

在现代数据同步场景中,增量同步是提高传输效率、降低网络带宽消耗、提升系统响应速度的关键技术。相比全量同步,增量同步仅传输文件的差异部分,极大减少了传输数据量。本章将深入解析增量同步的底层原理,探讨其优化策略,并结合实际场景分析大文件和大量小文件的同步优化方法。

4.1 增量同步的底层原理

增量同步的核心在于“差异识别”与“差异传输”。它通过算法判断源文件与目标文件之间的不同之处,仅将变化部分进行传输,从而节省带宽和时间。rsync 工具就是基于这种机制实现高效同步的经典代表。

4.1.1 文件块划分与哈希计算

增量同步的第一步是将文件划分为若干个固定大小的块(block),并对每个块计算哈希值。接收端通过比对本地已有的哈希列表,判断哪些块已经存在,哪些块需要重新传输。

# rsync 命令示例,启用增量同步

rsync -avz --inplace source/ destination/

-a:归档模式,保留权限、时间戳等属性-v:详细输出-z:压缩传输--inplace:直接写入目标文件,适合大文件

代码逻辑分析:

source/与destination/分别表示源路径与目标路径。- rsync 会将

source/中的文件进行分块处理,并计算每个块的哈希值。 - 接收端(destination)会对比本地已有的哈希值,仅传输不一致的块。

文件块划分流程图(mermaid):

graph TD

A[原始文件] --> B[划分成固定大小的块]

B --> C[计算每个块的弱哈希和强哈希]

C --> D[发送端发送哈希列表]

D --> E[接收端匹配本地哈希]

E --> F{是否有匹配块?}

F -- 是 --> G[跳过该块]

F -- 否 --> H[请求缺失块数据]

H --> I[发送端传输缺失块]

4.1.2 差分压缩与传输优化

rsync 使用了 rsync 算法 (也称“滚动哈希”)来进行差分计算。该算法通过滑动窗口的方式,快速识别出两个文件之间的差异部分,从而只传输变化内容。

优势:

- 减少传输数据量

- 支持断点续传

- 适用于远程备份和同步场景

4.1.3 rsync算法的时间与空间复杂度分析

- 时间复杂度:

- 文件块划分和哈希计算:O(n),n 为文件大小

- 哈希匹配:O(m),m 为已传输文件的块数量

- 空间复杂度:

- 需要保存本地文件的哈希列表,空间为 O(m)

虽然算法本身效率较高,但对大文件或海量文件同步时,仍需注意内存与CPU的使用情况。

4.2 提升增量同步效率的实践方法

虽然增量同步在理论上效率很高,但在实际使用中,还需要结合系统配置和使用方式进一步优化。以下是一些常见的提升效率的策略。

4.2.1 合理设置块大小与压缩级别

块大小(block size)是影响增量同步效率的重要参数。一般情况下,块大小越小,差分越精确,但计算开销也越大;块大小越大,则传输效率高但差分精度下降。

# 指定块大小为 2048 字节

rsync -avz --block-size=2048 source/ destination/

参数说明:

- --block-size=2048 :设置每个文件块大小为 2KB

压缩级别设置示例:

# 设置压缩级别为 3(默认为 6)

rsync -avz --compress-level=3 source/ destination/

压缩级别说明:

- 0:不压缩

- 1-9:压缩等级,数值越大压缩率越高,CPU消耗也越大

| 压缩级别 | 压缩率 | CPU 使用率 | 网络带宽消耗 |

|---|---|---|---|

| 0 | 无 | 低 | 高 |

| 3 | 中等 | 中 | 中 |

| 6 | 高 | 高 | 低 |

| 9 | 最高 | 极高 | 极低 |

4.2.2 利用硬链接与软链接减少重复传输

在同步大量重复文件时,可以使用硬链接(hard link)或软链接(symbolic link)来减少实际传输数据量。

示例:创建软链接

ln -s /original/path /link/path

ln -s:创建软链接/original/path:源文件路径/link/path:链接路径

优点:

- 软链接节省磁盘空间

- 只需同步源文件,链接文件自动同步

4.2.3 利用快照技术辅助增量备份

在文件系统层面(如 ZFS 或 Btrfs),可以使用快照技术记录文件变化,再结合 rsync 实现更高效的增量同步。

ZFS 快照示例:

# 创建快照

zfs snapshot tank/data@backup1

# 将快照挂载为只读目录

zfs mount tank/data@backup1

# 使用 rsync 同步快照目录

rsync -avz /tank/data@backup1 user@remote:/backup/

优势:

- 快照可快速捕获文件状态

- 与 rsync 结合可实现高效的增量备份

4.3 大文件与大量小文件的同步优化

在实际运维中,经常需要处理两类极端文件场景: 大文件 (如日志、视频)和 大量小文件 (如网页资源、配置文件)。这两类文件在同步时各有挑战,需采用不同的优化策略。

4.3.1 大文件断点续传机制

大文件同步过程中,如果中断会导致重新传输整个文件。rsync 提供了 --partial 和 --append 参数实现断点续传。

rsync -avz --partial --append source/largefile destination/

参数说明:

- --partial :保留部分传输的文件

- --append :以追加方式继续传输

流程说明:

- rsync 会记录已传输的部分

- 下次执行时继续传输未完成的部分

4.3.2 小文件合并传输策略

大量小文件在同步时会产生大量元数据请求,导致性能下降。可以通过合并文件或使用 tar 打包后再传输。

示例:打包传输

tar czf - /path/to/smallfiles | ssh user@remote "tar xzf - -C /remote/path"

优点:

- 减少文件数量,降低元数据开销

- 压缩后减少传输体积

适用场景:

- 网站资源、配置文件、日志等小文件集合

4.3.3 多线程与异步I/O支持

rsync 本身是单线程运行的,但在某些版本中可以结合 parallel 工具实现多线程同步。

并行同步示例:

find /source/dir -type f -name "*.log" | parallel -j 4 rsync -avz {} user@remote:/dest/

参数说明:

- find :查找所有 .log 文件

- parallel -j 4 :启动4个并发任务

- rsync :每个文件单独同步

性能对比表:

| 同步方式 | 传输时间(分钟) | CPU 使用率 | 适用场景 |

|---|---|---|---|

| 单线程 rsync | 25 | 中等 | 一般文件同步 |

| 多线程 + rsync | 8 | 高 | 小文件批量传输 |

| tar + ssh | 5 | 中等 | 小文件打包传输 |

| rsync + partial | 12(断点续传) | 中等 | 大文件不稳定环境 |

优化建议:

- 小文件优先使用打包压缩

- 大文件启用断点续传

- 对性能要求高的场景可使用多线程工具并行处理

通过本章内容的学习,读者可以掌握增量同步的核心机制,了解 rsync 的底层算法,并掌握在不同文件类型和环境下的优化策略。下一章将深入探讨大规模文件同步中的性能瓶颈及优化方案,进一步提升同步系统的整体效率。

5. 大规模文件同步性能优化

在处理大规模文件同步任务时,系统性能往往会成为制约效率的关键因素。本章将深入分析大规模文件同步过程中常见的性能瓶颈,并探讨如何通过分布式架构设计、缓存机制优化以及异步处理等手段,提升同步效率与系统稳定性。

5.1 大规模文件同步的性能瓶颈分析

在同步大量文件或大体积数据时,系统性能往往受到多个因素的影响。理解这些瓶颈是优化的前提。

5.1.1 网络带宽与延迟的影响

大规模文件同步通常涉及跨节点或跨地域传输,网络带宽和延迟是首要瓶颈。

- 带宽限制 :在千兆网络环境下,单个 rsync 连接的同步速度往往无法达到极限,尤其在传输大量小文件时,频繁的连接开销会进一步降低效率。

- 延迟问题 :高延迟(如跨数据中心)会显著影响 TCP 协议的数据传输效率,进而影响整体同步速度。

示例:监控网络传输效率

# 使用 rsync -P 查看传输进度与速度

rsync -avzP /source/ user@remote:/dest/

输出示例:

sent 123456 bytes received 789012 bytes 34567.89 bytes/sec

total size is 1234567890 speedup is 1234.56

5.1.2 磁盘I/O与CPU资源的消耗

rsync 在进行文件比较、差分计算、压缩等操作时,会占用大量 CPU 资源。同时,频繁的磁盘读写操作也会造成 I/O 瓶颈,尤其是在机械硬盘(HDD)环境下更为明显。

解决方案建议:

- 使用 SSD 提升 I/O 性能

- 合理设置压缩等级(如 --compress-level=3 )以降低 CPU 占用

5.1.3 元数据扫描与索引构建开销

rsync 在同步前会扫描整个目录结构并生成文件列表,这一过程在百万级文件数量下会显著影响性能。

性能优化技巧:

- 使用 --files-from 指定同步文件列表,减少全量扫描

- 配合 inotify 或定时扫描生成增量列表,减少重复扫描开销

5.2 分布式与集群化同步架构设计

面对 PB 级别的文件同步任务,单机部署往往无法满足性能需求。采用分布式与集群架构是提升同步效率的有效方式。

5.2.1 主从结构与负载均衡策略

采用主从结构可实现任务分发与集中管理。主节点负责任务调度,从节点负责实际文件同步任务。

架构示意图(mermaid 流程图):

graph TD

A[主节点] --> B[任务分发]

B --> C[从节点1]

B --> D[从节点2]

B --> E[从节点3]

C --> F[本地同步任务]

D --> F

E --> F

5.2.2 多节点并行同步方案

将大任务拆分为多个子任务,并行执行可显著提升同步效率。例如:

# 使用 xargs 并行执行 rsync

find /source -type d -name 'part*' | xargs -P 4 -I {} rsync -avz {} user@remote:/dest/

-P 4:表示同时运行 4 个并行任务-I {}:将{}替换为 find 找到的目录路径

5.2.3 中央控制节点与调度机制

通过中央调度系统(如 Ansible、SaltStack 或自研调度器)统一管理同步任务,确保任务分布合理、资源利用均衡。

调度系统关键功能:

- 任务优先级管理

- 故障自动重试

- 节点状态监控与动态调度

5.3 基于缓存与异步机制的性能提升

在同步过程中引入缓存和异步处理机制,可以有效缓解系统资源压力,提高整体同步效率。

5.3.1 利用内存缓存减少磁盘访问

将常用文件或文件元数据缓存在内存中,可减少磁盘 I/O 操作,提升同步速度。

Linux 系统中可使用 rsync --inplace 配合 tmpfs 提升缓存性能:

# 将临时文件写入内存文件系统

rsync -avz --inplace /source/ /mnt/ramdisk/

rsync -avz /mnt/ramdisk/ user@remote:/dest/

5.3.2 异步队列与批量处理优化

将同步任务提交至异步队列中进行批量处理,可避免资源竞争,提高系统吞吐能力。

示例:使用 RabbitMQ 实现异步任务队列

# 生产者(任务提交)

import pika

connection = pika.BlockingConnection(pika.ConnectionParameters('localhost'))

channel = connection.channel()

channel.queue_declare(queue='sync_tasks')

channel.basic_publish(exchange='', routing_key='sync_tasks', body='/source/dir1')

connection.close()

# 消费者(异步执行)

def callback(ch, method, properties, body):

os.system(f"rsync -avz {body.decode()} user@remote:/dest/")

channel.basic_consume(callback, queue='sync_tasks', no_ack=True)

channel.start_consuming()

5.3.3 利用CDN与边缘节点加速同步过程

对于跨地域、跨数据中心的同步任务,可借助 CDN 或边缘节点缓存热点数据,减少长距离传输延迟。

CDN 加速同步流程图:

graph LR

A[源服务器] --> B(CDN边缘节点)

B --> C[客户端节点]

C --> D[本地缓存]

- 源服务器将文件上传至 CDN

- CDN 将文件分发至各边缘节点

- 各客户端从最近的边缘节点下载文件,减少跨区域带宽消耗

本章通过分析大规模文件同步中的性能瓶颈,并结合分布式架构、缓存机制与异步处理等技术手段,探讨了提升同步效率的多种实现方式。这些优化策略为后续构建高可用、高性能的同步系统奠定了基础。

简介:该工具是一款支持Windows与Linux系统的开源文件同步解决方案,具备操作简便与高效处理能力,适用于多服务器或混合操作系统环境下的数据一致性维护。通过优化的同步算法,它可快速完成大量文件(如百万级小文件)的同步任务,并支持单向与双向同步模式。工具内置rsync技术,仅传输文件变化部分,节省带宽并提升效率。服务端与客户端架构便于用户灵活配置同步任务,适合网站备份、数据迁移及服务器集群维护等场景。依托开源社区,工具具备持续更新与完善的能力。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)