开源大模型工具对比

大模型(Large Language Model, LLM)是基于海量数据训练的深度学习模型,通常包含数十亿至数万亿参数,能够理解和生成自然语言,并完成复杂任务(如文本生成、代码编写、逻辑推理等)。规模庞大:参数规模远超传统模型,学习能力更强;通用性:通过预训练适应多种下游任务;涌现能力:在复杂场景中表现出未显式训练的推理能力。典型代表:GPT-4、Claude、LLaMA。LangFlow是一款

一、什么是大模型?

大模型(Large Language Model, LLM)是基于海量数据训练的深度学习模型,通常包含数十亿至数万亿参数,能够理解和生成自然语言,并完成复杂任务(如文本生成、代码编写、逻辑推理等)。其核心特点包括:

- 规模庞大:参数规模远超传统模型,学习能力更强;

- 通用性:通过预训练适应多种下游任务;

- 涌现能力:在复杂场景中表现出未显式训练的推理能力。

典型代表:GPT-4、Claude、LLaMA。

二、为什么需要大模型工具

大模型的开发和应用涉及复杂的流程和技术挑战,仅依赖底层模型(如GPT-4、Claude等)的API调用远远不够。大模型开发工具的出现,本质上是为了解决以下几个核心问题:

2.1 降低技术复杂性

大模型开发涉及多领域技术栈的整合,例如:

底层架构:如Transformer模型、向量数据库(Milvus、Pinecone)、检索增强生成(RAG)等。

工程化需求:模型微调(Fine-tuning)、提示工程(Prompt Engineering)、多模型协同调度等。

多模态处理:文本、图像、音频的联合处理与上下文对齐。

开发工具的作用:

封装技术细节:例如,Langflow和Flowise通过可视化界面将复杂的模型调用、数据检索、流程编排抽象为拖拽组件,开发者无需深入底层代码即可搭建应用。

预置标准化模块:例如Dify提供预训练的Embedding模型、文本分割器等,避免开发者重复实现基础功能。

2.2 提升开发效率

从零开始开发一个大模型应用可能耗时数周甚至数月,而开发工具通过以下方式大幅缩短周期:

模块化设计:例如,AutoGPT UI将任务拆解为“目标定义→子任务生成→执行→反馈”的标准化流程,开发者只需关注业务逻辑。

快速迭代:工具支持实时调试和可视化反馈(如AgentGPT的对话界面),减少代码修改和测试时间。

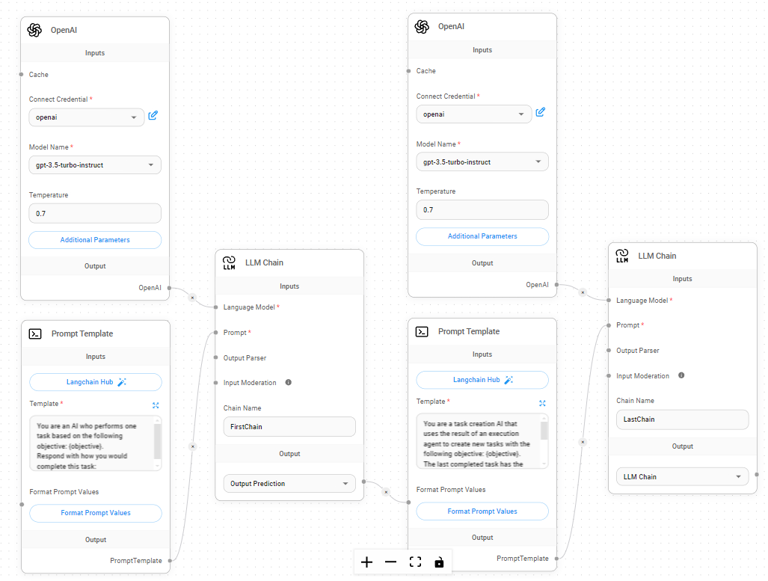

预集成生态:例如,Flowise内置对LangChain、OpenAI、Hugging Face模型的直接支持,省去API对接和兼容性调试。

下面介绍一些最近比较火的大模型开发工具,供大家参考。

三、大模型开发工具详解

3.1 Langflow

3.1.1 Langflow简介

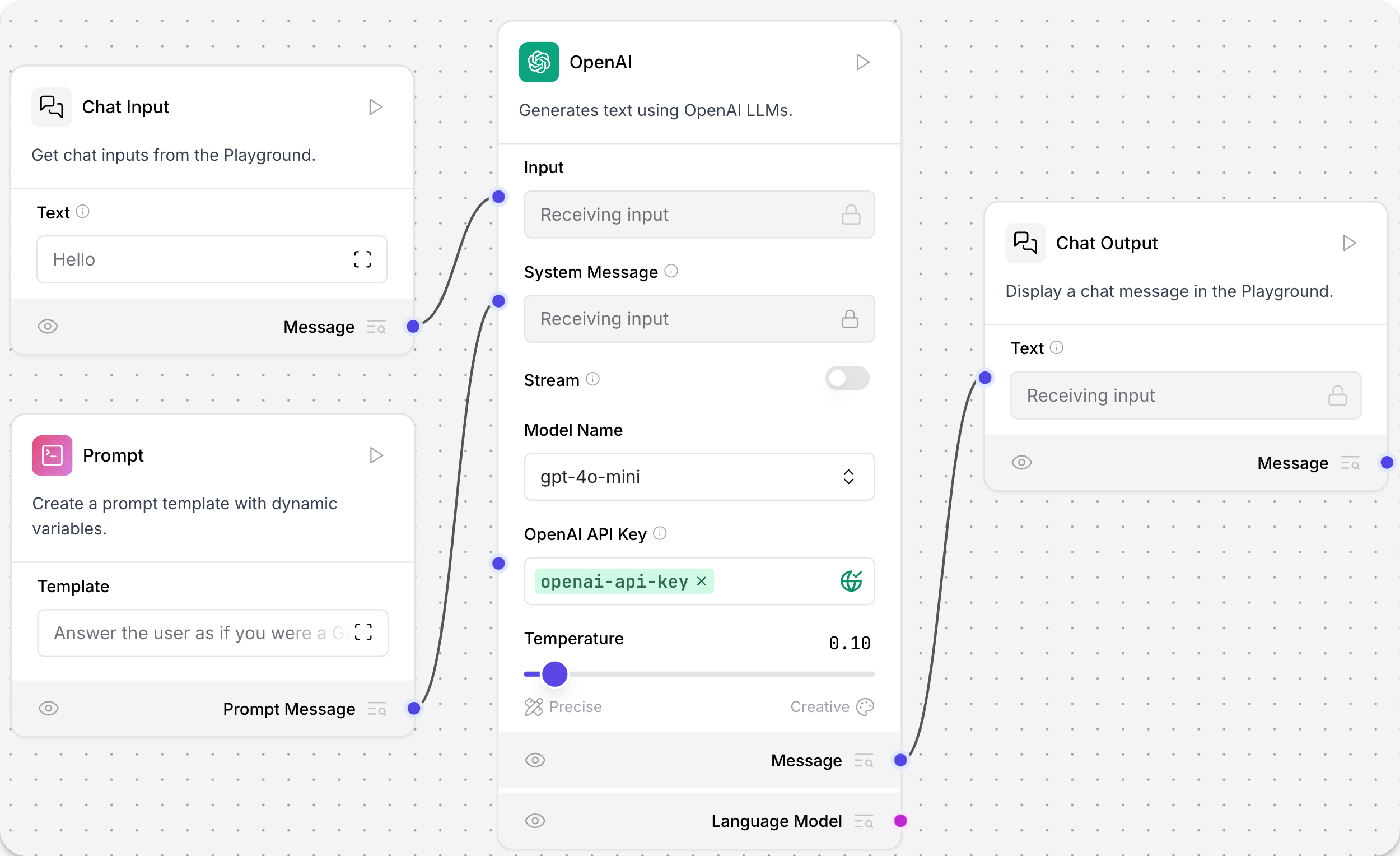

LangFlow 是一款低代码、可视化的 AI 应用构建工具,专为快速搭建和实验 LangChain 流水线而设计。通过拖拽式界面,用户可以轻松创建复杂的 AI 工作流,无需编写大量代码。它支持多代理对话管理和 RAG(检索增强生成)应用,适用于构建智能聊天机器人、文档分析系统和内容生成工具等场景。

LangFlow 提供了丰富的预构建组件和模板,用户可以通过 Python 代码对组件进行自定义,满足不同场景的需求。此外,用户可以将工作流以 API 形式发布,或导出为 Python 应用程序,方便集成到其他系统中。

3.1.2 Langflow核心功能

- 可视化工作流构建:通过拖拽组件,用户可以轻松创建复杂的 AI 工作流。

- 多代理支持:支持多代理的编排、对话管理和信息检索。

- Python 自定义:用户可以使用 Python 代码对组件进行自定义。

- 预构建组件:提供数百个预构建的组件和模板,方便快速开始项目。

- 即时测试环境:内置的 Playground 功能允许用户实时测试和迭代工作流。

- 云部署与本地运行:支持在 DataStax Langflow 云平台免费部署,也支持本地运行。

- API 发布与导出:用户可以将工作流发布为 API 或导出为 Python 应用程序。

- 生态系统集成:支持与 LangSmith、LangFuse 或 LangWatch 等工具集成,提供企业级安全性和可扩展性。

3.1.3 LangFlow 的技术原理

- 基于有向无环图(DAG)的执行引擎:当工作流运行时,LangFlow 会根据组件和连接线构建一个有向无环图(DAG)。DAG 的节点(组件)会按照依赖关系排序并依次执行,每个节点的输出结果会传递给依赖它的下一个节点,确保了工作流的高效执行和结果的正确性。

- 组件化设计与灵活性:LangFlow 的组件化设计支持用户根据需求选择或自定义组件。支持与多种模型、API 和数据库集成,开发者可以轻松扩展和复用组件。LangFlow 提供了数百个预构建的组件,满足不同场景的需求。

- RAG(检索增强生成)支持:LangFlow 提供了对 RAG 的支持,通过智能文本分块模块将长文档结构化存储到向量数据库中,在查询时通过向量检索快速定位相关信息。

- Python 驱动与开源特性:LangFlow 基于 Python 开发,完全开源,用户可以通过 Python 完全自定义工作流或扩展功能。

3.2 Flowise

3.2.1 Flowise简介

Flowise 是一个开源项目,将永远免费供商业和个人使用。

Flowise 基于 ️ LangChain.js,是一个非常先进的图形用户界面,用于开发基于 LLM 的应用程序。这些应用程序也称为 Gen Apps、LLM Apps、Prompt Chaining、LLM Chains 等。

Flowise 是专门为 LangChain 打造的用户界面 (UI),利用了 React-Flow 技术。其目的是提供一个无缝平台,用于轻松进行流程实验和原型设计。用户可以享受拖放组件和聊天框功能的便利,以增强他们的体验。

3.2.2 Flowise核心功能

- 可视化设计 - 通过拖拽创建AI应用,无需编码。

- 多模型集成 - 支持多种大语言模型,包括OpenAI、HuggingFace等。

- 灵活部署 - 支持自托管,适合不同安全需求。

- 团队协作 - 多租户管理,适合团队合作开发。

- 监控与日志 - 实时监控和详细日志,便于故障排查。

- 高度定制 - 允许深度定制和脚本插入,满足特定需求。

3.3 Dify

3.3.1 Dify 简介

Dify 是一款开源的大语言模型(LLM) 应用开发平台。它融合了后端即服务(Backend as Service)和 LLMOps 的理念,使开发者可以快速搭建生产级的生成式 AI 应用。即使你是非技术人员,也能参与到 AI 应用的定义和数据运营过程中。

由于 Dify 内置了构建 LLM 应用所需的关键技术栈,包括对数百个模型的支持、直观的 Prompt 编排界面、高质量的 RAG 引擎、稳健的 Agent 框架、灵活的流程编排,并同时提供了一套易用的界面和 API。这为开发者节省了许多重复造轮子的时间,使其可以专注在创新和业务需求上。

3.3.2 Dify核心功能

- 提示词与变量插入:允许用户在提示词中插入变量,如{{input}},以动态生成对话内容,实现个性化交互。

- 应用编排:用户可以轻松编排对话流程,添加不同的对话开场白,调整对话逻辑,满足特定场景需求。

- 上下文管理:支持设置对话上下文,限制AI的响应范围,确保对话内容的专业性和准确性,可引用知识库来增强对话质量。

- 调试与优化:提供实时调试功能,用户可以直接输入测试内容,查看AI的响应,并根据需要调整提示词或切换底层模型,以优化对话效果。

- 发布与集成:完成应用设计后,可以一键发布,生成独立的AI应用。支持通过APIs进行二次开发,轻松嵌入网站或应用中。

- 模板与工作流:提供多种应用模板快速启动项目,包括聊天助手、文本生成等。Chatflow支持记忆功能,而工作流则针对单轮任务自动化。

3.3.3 Dify技术原理

该架构采用分层设计,自上而下可分为四层:

- 数据层:

包含Dataset(数据集)和Prompts(提示词)两个输入源,通过ETL进行数据处理,并由RAG Pipeline实现知识检索增强。 - 开发层:

提供Prompts IDE和Agent DSL两大开发工具,前者用于提示词的编写和管理,后者用于构建智能代理。 - 编排层:

以Orchestration Studio为核心,负责协调各个组件的运行,并通过Moderation System(审核系统)和Cache System(缓存系统)保障应用质量。 - 基础层:

包括Storage(存储系统)和LLMs(语言模型)两大基础设施,为上层提供支撑。

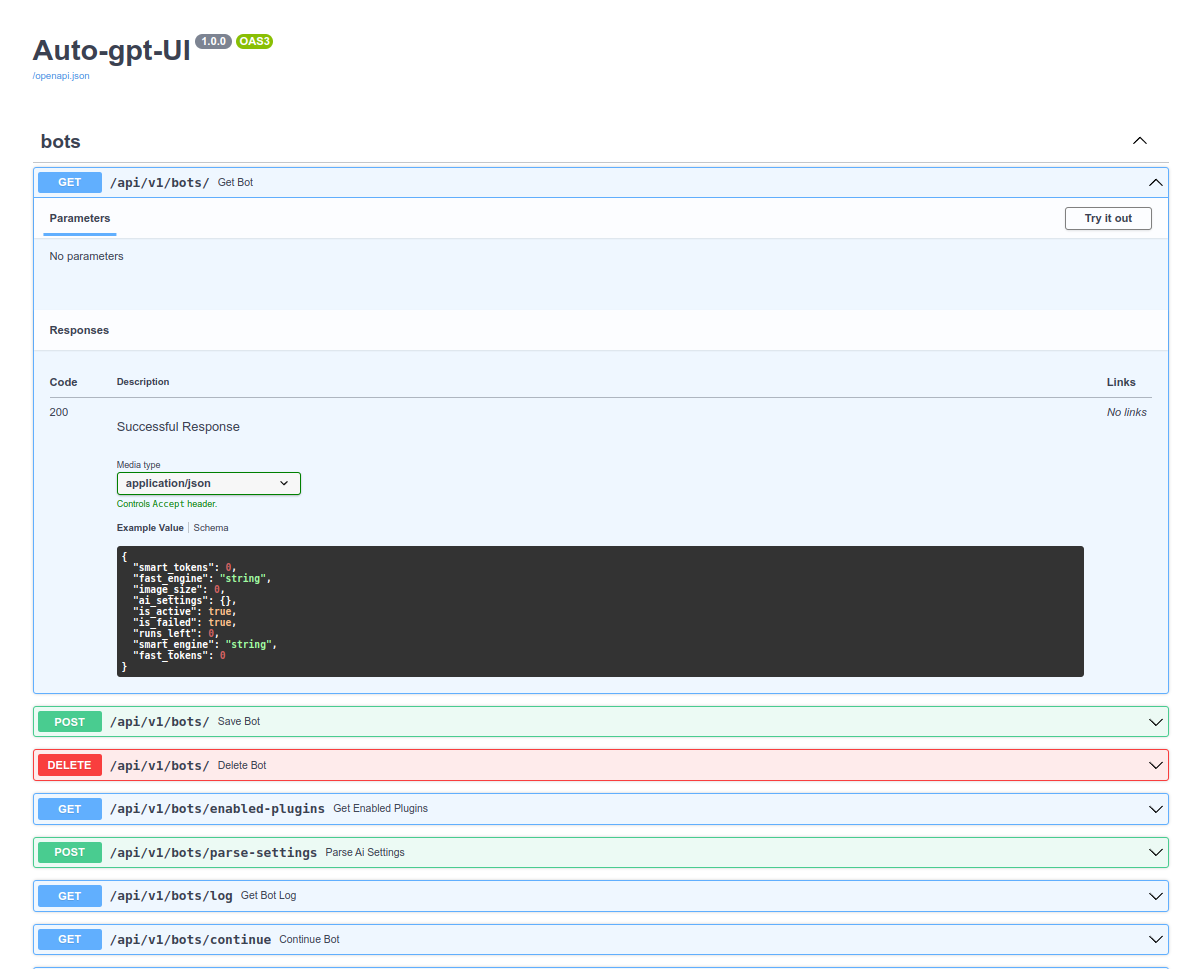

3.4 AutoGPT UI

3.4.1 AutoGPT UI简介

AutoGPT UI 是一个为 AutoGPT 项目开发的图形用户界面(Web UI),它极大地简化了用户与这一强大AI工具的交互过程。这一界面的推出,主要是为了克服之前仅能通过命令行界面(CLI)操作的局限性。

3.4.2 AutoGPT UI核心功能:

- 用户友好界面:提供清晰的步骤引导,用户可以轻松输入AI角色描述、具体目标等信息,减少了技术门槛。

- 目标设定与分解:用户在UI中设定目标后,AutoGPT会自动将这些目标拆解成一系列小任务,通过Web界面直观展示这一过程。

- API密钥管理:用户可以在UI中安全地管理OpenAI API密钥,确保数据和访问的安全性。

- 任务执行与监控:用户可以启动任务,并通过UI实时监控任务执行状态,包括每个小任务的完成情况和反馈。

- 本地运行选项:对于需要更高效率或对数据隐私有特殊要求的用户,UI提供了下载代码到本地运行的选项,绕过HuggingFace的服务器限制

3.4.3 AutoGPT 简介

AutoGPT 是一个基于人工智能的开源项目,它利用了先进的语言模型,特别是GPT-4和GPT-3.5系列,来自动执行一系列复杂的任务。这个工具的设计初衷是为了简化和自动化文本生成、信息搜索、编程代码编写等过程,使得用户能够通过设定具体目标,让AI自主地完成从规划到执行的整个流程,而无需人工逐个指导每一步。

其实 AutoGPT 没有 UP 圈吹的那么厉害,实现原理很简单,只能说作者很聪明和偷巧,充分利用自动化脚本和 GPT 编写人设的能力完成了 GPT 对问题的自我迭代,同时引入了内存管理机制保存上下文方便其回顾,支持 Google 等各种外部指令方便其搜索纠错(后续有可能会支持更多语言编译和执行环境),但缺点也是非常明显的,目前 GPT4 高昂的费用,对于一个小任务,基本上就需要消耗大概 几十个步骤来完成,,如果家里没矿建议不要用它搞着玩,此外 GPT 3.5 非常容易逃逸或者陷入死循环。

3.5 AgentGPT

3.5.1 AgentGPT简介

AgentGPT是一个基于大型语言模型(如GPT-4)的自主AI代理平台,特别设计用于在浏览器环境中运行。它由Reworkd团队开发,并作为一个开源项目托管在GitHub上,拥有超过29.9K星标,表明了其在社区中的受欢迎程度和影响力。AgentGPT的核心理念是让用户能够轻松创建、配置和部署具有特定目标的智能代理,无需复杂的安装过程或深厚的编程知识。

3.5.2 AgentGPT核心功能

- 浏览器端AI代理配置平台

- 目标导向的任务规划(如"制定社交媒体推广策略")

- 自动生成执行步骤和进度报告

四、工具对比总结

| 维度 | Langflow | Dify | Flowise | AutoGPT UI | AgentGPT |

|---|---|---|---|---|---|

| 学习曲线 | 需Python基础 | 中等 | 无需编程 | 较高 | 低 |

| 扩展性 | ★★★★★ | ★★★★★ | ★★★☆☆ | ★★☆☆☆ | ★☆☆☆☆ |

| 部署难度 | 本地/云 | 私有化复杂 | Docker简易 | 本地配置难 | 纯浏览器 |

| 适用规模 | 中大型团队 | 企业级 | 个人/小团队 | 实验性项目 | 个人使用 |

选择指南:

- 追求极致控制:Langflow + 自建模型

- 快速上线需求:Flowise + OpenAI API

- 企业合规场景:Dify 私有化部署

- 自动化探索:AgentGPT(轻量) vs AutoGPT(深度)

目前主要流行的是Langflow与Dify,当然coze也很厉害,但是它不开源且不能本地部署,不适用与开发使用,因此不在考虑范围内。Dify是国内开发的,使用起来更顺手,且嵌入当到已有应用中十分便捷,个人比较推荐。

下一篇,我们分享关于Dify使用的系列文章,期待您的关注。

我们组建了一个Dify的互助群,欢迎来求助或分享你与Dify的相爱相杀。

联系方式在 DataSpeed 公众号里,或者私信我。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)